Перспективные технологии: итоги и прогнозы

Анализ бизнес-процессов и управление ими

Средства анализа бизнес-процессов

Средства управления бизнес-правилами

Инфраструктура бизнес-приложений

Архитектура, управляемая моделью

Архитектура, ориентированная на сервисы

Архитектуры, основанные на службах данных

Хранилища данных бизнес-приложений

Управление информационными активами предприятия

Управление информационным наполнением

Средства повышения эффективности работы и поддержки принятия решений

Технологии поиска в медиаданных

Открытые форматы офисных документов (Open XML, OpenDocument)

Офисные пакеты на основе Web 2.0

Excel как клиентская часть аналитических приложений

Программное обеспечение для информационной безопасности

Доступ с помощью единой «точки входа»

Мониторинг и предотвращение активности приложений

Программное обеспечение с открытым кодом

Серверы приложений Java EE с открытым кодом (Open-Source Java EE Application Servers)

Серверные операционные системы с открытым кодом

Linux как корпоративная настольная ОС

Средства разработки с открытым кодом (Open-source application development tools)

Управление предоставлением ИТ-услуг

Information Technology Infrastructure Library

Средства управления портфелями ИТ-услуг

Управление информационным наполнением веб-сайтов

Дисплеи, проецирующие изображение на сетчатку

Дисплеи на базе бистабильных ЖК-структур (ChLCD и PABN LCD)

Дисплеи на базе технологий SED, FED и NED

Интерфейсы «компьютер — человек»

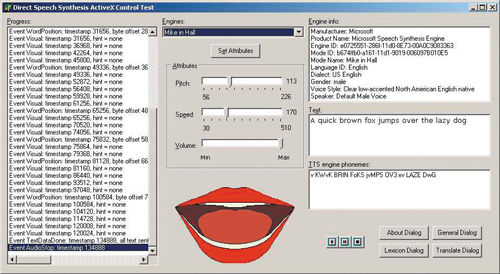

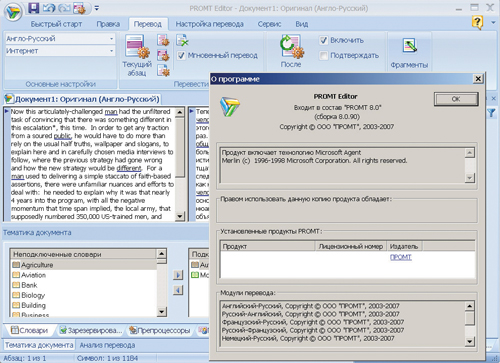

Автоматизированный синхронный перевод (Speech-to-Speech Translation)

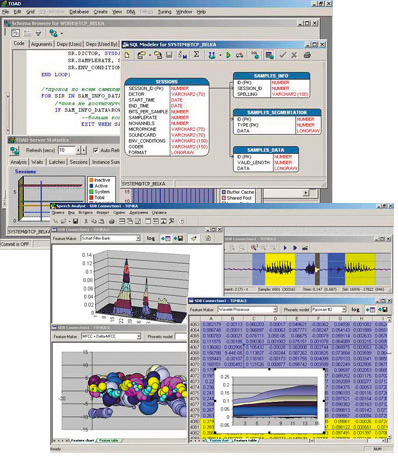

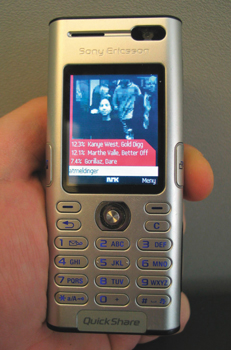

Распознавание речи для мобильных устройств

Распознавание речи в телефонии и в приложениях для информационных и справочных служб

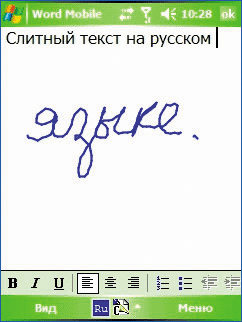

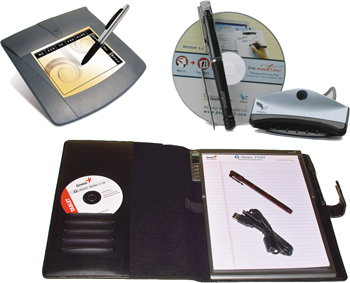

Распознавание рукописного текста

Распознавание жестов (Gesture Recognition)

«Умные» ткани (Fabric Sensors)

Системы платежей на базе бесконтактных чипов (NFC)

Сотовые сети четвертого поколения (4G)

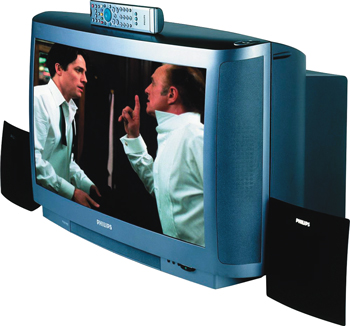

Цифровое телевидение высокой четкости (HDTV)

Стационарное цифровое телевидение (эфир)

Цифровое ТВ для мобильных телефонов

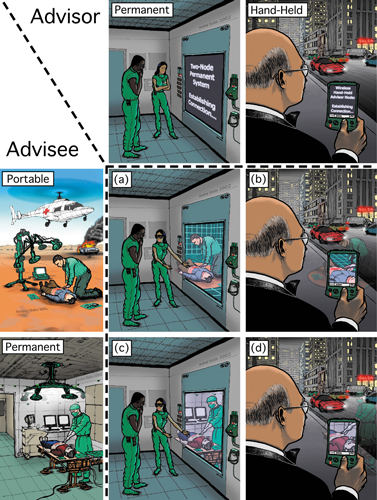

Телеприсутствие (Telepresence)

Потоковое видео и безленточные технологии

Технологии обработки данных с учетом местоположения (Location-Aware Technology)

Сервисы, базирующиеся на местоположении (Location-Based Services)

Приложения, работающие с учетом местоположения (Location-ware applications)

Технология ДНК-вычислений (DNA Logic)

Транзисторы на углеродных нанотрубках

Перспективные технологии памяти

Технологии создания элементной базы

Иммерсионная литография (Immersion Lithography)

Создание новых технологий, их развитие и воплощение в коммерческих продуктах — процесс непрерывный и закономерный. Без появления новых технологий остановился бы технический прогресс, а рыночную экономику ждал бы неминуемый коллапс. Однако каждая из новых разработок имеет свои особенности и определенный потенциал. Если одни могут лишь незначительно улучшить существующие решения, то другие способны совершить настоящий переворот в той или иной отрасли ИT-индустрии. Можно ли заранее оценить перспективность той или иной технологии?

К счастью, новые технологии появляются не каждый день. Это оставляет нам шанс разобраться в них раньше, чем они устареют и сойдут со сцены. Адекватная оценка потенциала готовящихся к выходу на рынок технологий важна для всех: пользователи получают стимул приобрести продукты с принципиально новыми возможностями, производители — расширить и разнообразить линейку предлагаемых решений, а бизнесмены — сделать выгодные инвестиции и получить хорошую прибыль.

Самостоятельно разобраться во всем многообразии современных ИT-технологий довольно сложно, и здесь на помощь приходят аналитики, обобщающие поток поступающих из различных источников данных и представляющие их в доступной для понимания форме. Одним из наиболее наглядных способов систематизации данных о развитии каких-либо процессов является графическое представление. Специалисты агентства Gartner, одного из ведущих мировых центров в области анализа современных ИT-технологий, создали графическую модель для представления данных о развитии новых технологий. Она получила название Hype Cycle, которое можно перевести как «цикл ажиотажа».

В соответствии с концепцией данной модели каждая новая технология в процессе своего развития проходит пять стадий, соответствующих определенной области графика (см. рисунок). Рассмотрим особенности каждого из этих периодов:

- Восход надежд (On the rise/Technology trigger) — область концептуальных технологий, обладающих, по мнению аналитиков и разработчиков, наиболее высоким потенциалом. Их ценность, как правило, не вызывает вопросов, но они являются еще недостаточно зрелыми для привлечения больших инвестиций и внедрения в коммерческих продуктах.

- Пик завышенных ожиданий (At the peak/Peak of inflated expectations) — на этой стадии начинается массированная пропаганда преимуществ новой технологии в СМИ, привлекающая внимание общественности, а также потенциальных инвесторов и производителей. Стоит отметить, что подобные информационные кампании редко обходятся без явных спекуляций: аналитики с энтузиазмом пишут радужные отчеты о перспективах (зачастую умалчивая об уже известных недостатках и ограничениях) и прогнозируют вытеснение традиционных технологий по мере повсеместного внедрения новинки. Инвесторы, соблазненные грандиозными перспективами, начинают вкладывать средства в исследовательские работы и создание работающих прототипов; конкуренты, почуяв запах денег, предлагают собственные клоны данного решения. Как правило, основания для оптимизма в большинстве случаев действительно есть, однако их масштабы сильно преувеличены. Инвестиции на данном этапе рискованны, так как потенциал технологии может быть сильно переоценен. В некоторых случаях широко разрекламированное решение и вовсе оказывается пустышкой, сознательно раздутой для получения крупных грантов под те или иные исследования, представляющие интерес исключительно с точки зрения развития академической науки.

- Котловина разочарований (Sliding into the trough/Trough of disillusionment) — после относительно недолгого периода раскрутки новинка либо сходит со сцены, либо занимает свое место в существующей инфраструктуре рынка. Энтузиазм сходит на нет, незадачливые инвесторы подсчитывают убытки, аналитики пишут отчеты о причинах неудач, а в глазах конечных пользователей широко разрекламированное решение теряет свою привлекательность. На этой стадии формируется негативное отношение к технологии, которая, с одной стороны, уже утратила статус новинки, а с другой — еще не продемонстрировала инвесторам и потенциальным пользователям свои убедительные преимущества по сравнению с существующими решениями. В процессе тестирования первых прототипов выявляется ряд существенных недостатков, которые отпугивают заинтересованных производителей. Мыльный пузырь, раздутый прессой вокруг перспективной разработки, лопается. Количество публикаций и упоминаний резко идет на убыль, и у многих создается впечатление, что данная технология ушла со сцены. Однако этот этап может оказаться наиболее привлекательным для инвесторов, так как перспективы применения данной технологии постепенно проясняются, а разработчик (или обладатель прав на изобретение), в связи со спадом интереса к технологии, становится более сговорчивым.

- Подъем жизнестойкости (Climbing the slope/Slope of enlightenment) — начинается новая стадия исследований, в ходе которой разработчики устраняют выявленные ранее недостатки, а также оптимизируют технологический процесс с учетом требований серийного производства. Начинается внедрение технологии в коммерческих продуктах. По мере роста количества пользователей и примеров успешной реализации данного решения наступает признание — сначала в среде специалистов, а затем и общественности. Инвестиции на данном этапе наименее рискованны, однако именно в этот момент крупные игроки соответствующего сегмента рынка стремятся поглотить небольшую компанию, сумевшую довести перспективную разработку до стадии серийного или предсерийного производства, — иногда для того, чтобы внедрить данную технологию в собственных изделиях, а в некоторых случаях, чтобы устранить потенциального конкурента и предать оригинальное изобретение забвению. Иногда небольшие компании-разработчики на этом этапе трансформируются в акционерные общества и входят в альянсы с одним или несколькими крупными игроками соответствующего сегмента рынка.

- Плато продуктивности (Entering the plateau/Plateau of productivity) — на этой стадии технология выходит на промышленный уровень и становится стабильно прибыльной, универсальной, общепризнанной и широко применяемой.

Стоит отметить, что развитие технологий по описанной модели в разные периоды происходит с различной скоростью. Более того, вовсе не обязательно, чтобы какая-то отдельно взятая технология последовательно проходила все пять этапов. Некоторые способны перескочить через тот или иной этап, в то время как другие периодически возвращаются на исходные позиции и начинают свой путь заново (такой цикл может повторяться несколько раз). Подобное происходило со многими технологиями — от распознавания рукописного ввода (сделав крупные инвестиции в ее развитие, компании из калифорнийской Кремниевой долины потеряли в общей сложности порядка миллиарда долларов) до Интернета (вспомните массовое разорение владельцев доменов зоны «.com»). Однако сегодня решения, которые когда-то уже вызывали разочарование (о чем все уже забыли), вновь обретают популярность.

Графическое представление модели Hype Cycle

Многие считают, что в современных условиях залогом успеха является первенство выхода на рынок с какой-то новой идеей или изобретением. Но в реальности рыночная ниша для новой технологии очень часто оказывается слишком узкой, а компании-производители, ухватившиеся за «перспективную» разработку и вложившие в ее развитие свои средства, слишком поздно это понимают. В ряде случаев потенциальные клиенты и партнеры оказываются просто не готовыми к применению новых технологий.

Более того, даже если ниша достаточно велика и рынок готов к принятию новой идеи, то разработчикам необходимо отразить атаки конкурентов, работающих над воплощением похожих решений. Компании, которые не могут постоянно разрабатывать новые способы эффективного использования своих ресурсов, отбрасываются на обочину рынка, где им остается бороться только за стремительно сокращающиеся рыночные ниши.

В этом обзоре мы рассмотрим технологии, которые упоминались аналитиками в 2008 году в числе наиболее перспективных.

Анализ бизнес-процессов и управление ими

Средства анализа бизнес-процессов

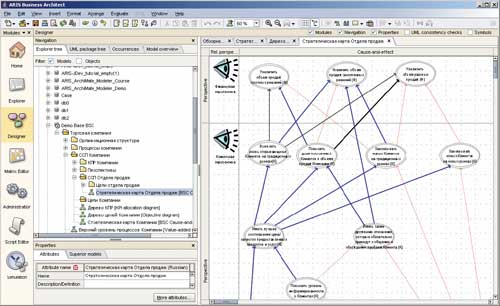

Моделирование и анализ бизнес-процессов используются совместно бизнес-пользователями и ИТ-специалистами с целью усовершенствования самих процессов и их ИТ-поддержки. В последние годы средства моделирования и анализа бизнес-процессов таких компаний, как IDS Scheer, Casewise, IBM, Microsoft и QPR, активно применяются как в проектах разработки и внедрения информационных систем, так и в проектах, посвященных анализу и совершенствованию процессов, разработке стратегии развития предприятий, совeршенствованию систем управления, разработке систем мотивации персонала.

К сожалению, в условиях экономического кризиса подобные проекты — это то, от чего многие компании вынуждены отказаться, оставив, возможно, подобную деятельность в минимальном объеме, необходимом для повышения эффективности управления в условиях недостаточной прибыли. Поэтому не исключено, что направление развития программного обеспечения для анализа бизнес-процессов может претерпеть определенные изменения, вызванные рыночной ситуацией, к примеру, за счет активного развития функциональности, ориентированной на разработку и внедрение информационных систем, либо за счет более гибкой лицензионной политики.

Управление бизнес-процессами

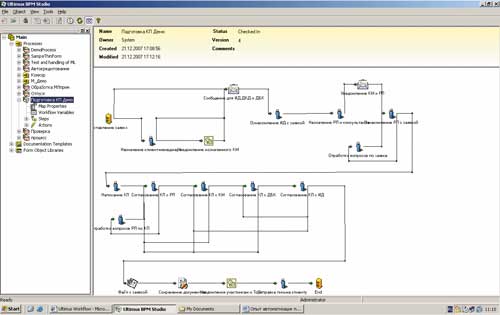

Управление бизнес-процессами — это один из современных принципов управления деятельностью компании, основанный на представлении деятельности в виде совокупности процессов, охватывающих разные подразделения. Хотя сам процессный подход к управлению предприятием не предполагает обязательного использования специализированных инструментов для управления бизнес-процессами, они, тем не менее, очень часто внедряются наряду с внедрением собственно процессного управления. Средства управления бизнес-процессами (называемые иногда workflow-системами) делают процессы прозрачными и позволяют получить их количественные характеристики. Указанные средства поддерживают всевозможные механизмы взаимодействия между исполнителями процесса и различные виды правил и алгоритмов выполнения процесса, содержат средства интеграции с бизнес-приложениями и офисным ПО, инструменты уведомления пользователей о задачах и событиях, а также средства моделирования выполнения процессов.

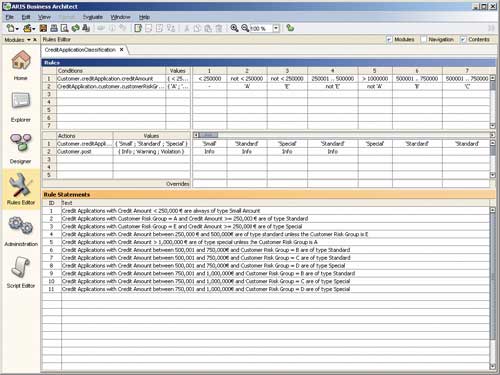

Средство моделирования и анализа бизнес-процессов

ARIS Business Architect (IDS Scheer)

Согласно прогнозам аналитиков, массовое применение подобных инструментов начнется только через несколько лет, хотя в таких секторах экономики, как телекоммуникации и финансовый сектор, они уже довольно активно применяются. В условиях экономического кризиса внедрение подобных приложений будет, по-видимому, продолжено, поскольку их применение позволяет существенно сократить затраты компаний на персонал.

Средство управления бизнес-процессами

Ultimus BPM Suite

Средства управления бизнес-правилами

Средства управления бизнес-правилами (Business Rule Engines) — это программное обеспечение, позволяющее определять, выполнять, проверять и поддерживать определенную бизнес-логику (называемую бизнес-правилами), описанную в виде деревьев решений, таблиц или иных способов описания алгоритмов. Средства управления бизнес-правилами обычно отделяют представление правил от механизмов их исполнения, позволяют находить несоответствия и противоречия в наборе правил, проверять их на полноту. Подобного рода средства могут существовать в виде как отдельных продуктов, так и составных частей другого программного обеспечения, например средств моделирования бизнес-процессов или бизнес-приложений. Применяются они, как правило, при принятии решений, основанных на соблюдении тех или иных правил.

Средство управления бизнес-правилами ARIS Business Rules Designer

(IDS Scheer)

В настоящее время интерес к подобным инструментам довольно высок, хотя до их массового применения во всех отраслях экономики еще далеко — пока наиболее очевидной сферой их использования являются крупные кредитные предприятия и финансовые учреждения. Тем не менее сегодня применение подобных инструментов не должно заметно снизиться, поскольку в условиях кризиса поддержка принятия решений по-прежнему важна.

Инфраструктура бизнес-приложений

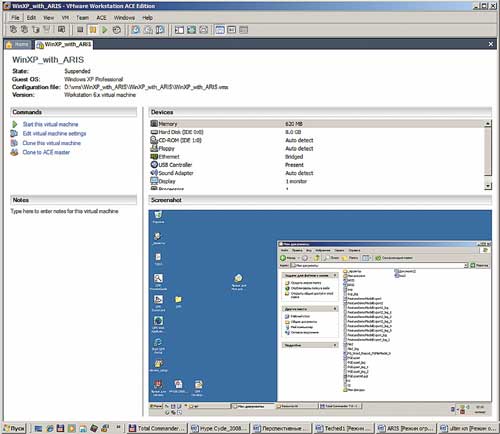

Виртуализация

Виртуальные машины — это технология одновременного выполнения нескольких операционных систем на одном компьютере. Данная технология известна очень давно — виртуальные машины для мэйнфреймов (в том числе и для отечественных — серии ЕС ЭВМ) широко использовались еще в начале 80-х годов. Однако ее активное применение на платформах, отличных от мэйнфреймов, началось примерно семь-восемь лет назад — именно тогда появились первые средства создания виртуальных машин для Windows и Linux от компаний VMware и Connectix (впоследствии ставшей частью корпорации Microsoft). Возможность оптимизации затрат на аппаратное обеспечение в то время привлекала разработчиков ПО, специалистов по конфигурационному управлению, тестированию и внедрению приложений, поэтому пик популярности указанного направления был достигнут очень быстро, особенно в связи с тем, что в 2000-2001 годах начали появляться и первые серверные решения для виртуализации.

Данное направление весьма привлекательно для многих компаний вследствие того, что им предоставляется возможность существенного снижения совокупной стоимости владения ИТ-инфраструктурой, и за прошедший год интерес к нему резко возрос в связи с появлением множества надежных и защищенных решений на основе технологий виртуализации — от Windows Azure и гипервизоров от разных производителей до решений с открытым кодом. Можно предположить, что интерес к этому направлению в условиях экономического кризиса будет расти и дальше, поскольку применение виртуализации может быть весьма эффективным способом снижения затрат на ИТ-инфраструктуру.

VMWare Workstation

Архитектура, управляемая моделью

Архитектура, управляемая моделью (Model-Driven Architecture, MDA), представляет собой предложенный консорциумом Object Management Group подход к отделению бизнес-функциональности приложений от технических особенностей их реализации. Данный подход основан на описании функциональности с помощью модели (например, UML-модели) и чтении этой модели с целью реализации описанной в ней функциональности на этапе выполнения приложения. В настоящее время к подобной технологии наблюдается повышенный интерес, что проявляется в появлении ее множественных реализаций, в том числе и от таких известных производителей ПО, как Microsoft. Это означает, что активное использование подобной технологии может начаться достаточно быстро, и экономический кризис вряд ли окажет существенное влияние на ее развитие.

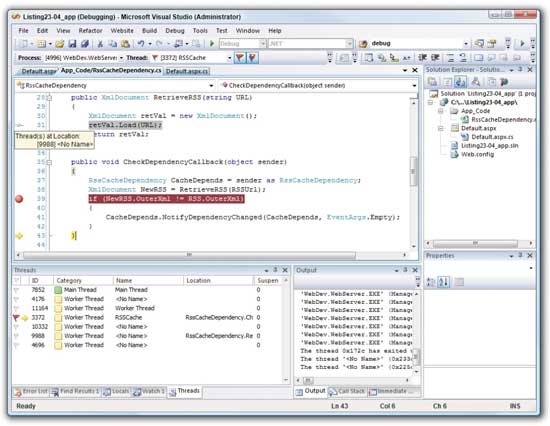

Архитектура, ориентированная на сервисы

Архитектура, ориентированная на сервисы (Service-Oriented Architecture, SOA), — это архитектура распределенных приложений, основанная на применении разделяемых интерактивных модулей, доступных в масштабе предприятия (а возможно, и за его пределами), обрабатывающих запросы с помощью стандартных интерфейсов. Толчком к развитию данного семейства технологий послужило развитие веб-служб, быстрое появление индустриальных стандартов в этой области и интерес крупных корпоративных пользователей к веб-службам как к реальному способу обеспечения интеграции между технологически несовместимыми приложениями и платформами. Одним из преимуществ применения SOA является сокращение времени и стоимости адаптации ИТ-инфраструктуры и приложений к изменяющимся бизнес-процессам по сравнению с традиционными архитектурами.

Visual Studio 2008

В условиях экономического кризиса использование архитектуры, ориентированной на сервисы, может стать более популярным за счет пересмотра ИТ-стратегий в компаниях, на развитие которых кризис оказал негативное влияние, в пользу сохранения унаследованных несовместимых платформ и решений даже при наличии определенных технических трудностей при внедрении.

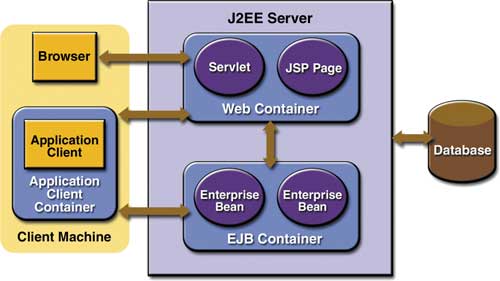

J2EE

Java 2 Platform, Enterprise Edition (J2EE) — разработанная компанией Sun Microsystems платформа для создания многозвенных бизнес-приложений с высокими требованиями к надежности и переносимости, которые выполняются под управлением различных операционных систем и используют в качестве инфраструктурного ПО серверы приложений, предоставляющие несколько стандартных программных интерфейсов для выполнения бизнес-объектов (таких как сервлеты, компоненты Enterprise JavaBeans и пр.).

Архитектура J2EE-приложений

В данный момент J2EE широко применяется в корпоративных решениях ведущих производителей ПО, в том числе IBM, Oracle, Novell, обеспечена достаточным количеством стандартов и поддерживается сообществом разработчиков с открытым кодом. Фактически эта технология уже находится на плато продуктивности, и экономический кризис не должен оказать существенного влияния на ее популярность.

Microsoft .NET

Microsoft .NET представляет собой платформу для разработки бизнес-приложений масштаба предприятия и web-приложений с высокими требованиями к надежности, входящую в состав последних версий операционных систем семейства Windows и некоторые другие решения для распределенных вычислений (Wndows Azure, Silverlight 2). На ее реализацию определенное влияние оказала платформа J2EE — при создании .NET в Microsoft постарались учесть многие ее недостатки, например использование единственного языка программирования.

Активное применение и рост популярности этой платформы ни у кого уже не вызывает сомнений — несмотря на доступность только для одного семейства операционных систем, указанная технология поддерживается ведущими производителями бизнес-приложений. Окончательный выход этой платформы на плато продуктивности можно ожидать в ближайшие год-два, и, как и в случае платформы J2EE, экономический кризис не должен оказать заметного влияния на этот процесс.

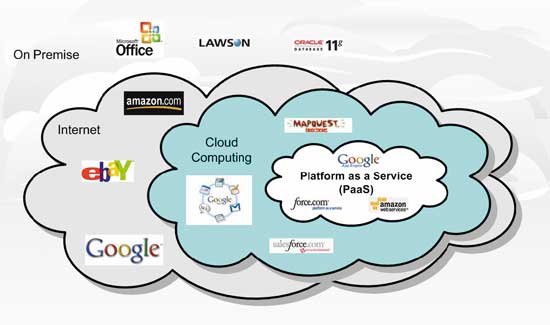

Cloud Computing

Термином Cloud Computing называют архитектуру приложений, основанную на их выполнении на серверах удаленных центров обработки данных (в так называемом облаке). При использовании подобной архитектуры поставщик приложений обычно предоставляет набор служб для доступа к функциональности приложений, хранения данных, а нередко и для внедрения в «облако» собственных приложений. Подобная архитектура приложений стала применяться в последние два года в основном компаниями, лидирующими в области присутствия в Интернете (такими как Google и Amazon), а в последнее время данной концепции особое внимание уделяют и такие лидеры рынка ПО, как Microsoft, анонсировавшая недавно собственную среду исполнения «облака» — Windows Azure.

Перенос приложений в «облако» позволяет отказаться от локальных серверов и тем самым сократить затраты на аппаратное обеспечение и обслуживание приложений. Есть предположение, что компании пойдут на использование подобной архитектуры по разным причинам, таким как обеспечение надежности и защиты данных, преодоление проблем, связанных с ограничениями в законодательствах разных стран, упрощение развертывания приложений и обеспечение доступа к ним из разных мест. Не исключено, что применение подобных технологий в условиях кризиса для многих компаний может оказаться весьма привлекательной альтернативой развитию собственной ИТ-инфраструктуры.

Управление данными

Архитектуры, основанные на службах данных

Архитектуры, основанные на службах данных (Data Service Architectures), представляют собой способ организации доступа к данным, в котором их местоположение, способ хранения и механизм доставки скрыты от конечного пользователя. Подобная стратегия доступа к данным представляет собой разновидность архитектуры, ориентированной на сервисы (Service Oriented Architecture), причем подавляющее большинство производителей СУБД и ПО промежуточного слоя, например Business Objects, IBM, Oracle и Microsoft, уже объявили о своих стратегических планах развития данного направления. Так, службы данных Microsoft SQL Services являются частью анонсированной этой компанией технологии Windows Azure.

Хранилища данных бизнес-приложений

Хранилища данных бизнес-приложений (Business Application Data Warehouses) представляют собой средства бизнес-анализа и хранения необходимых для его осуществления данных, встроенные в бизнес-приложения или предлагаемые производителями бизнес-приложений в качестве отдельного модуля. Как правило, подобные модули включают средства извлечения данных из оперативных БД, готовые модели данных для создания хранилищ, предварительно настроенные шаблоны отчетов, готовые запросы, OLAP-кубы, ключевые показатели результативности, бизнес-правила и алгоритмы выполнения бизнес-процессов. В последнее время было проведено немало проектoв внедрения подобных хранилищ, в основном входящих в состав бизнес-приложений SAP и Oracle. Однако такие проекты могут оказаться слишком дорогими, и в условиях кризиса компании обратят внимание на менее эффективные, но более дешевые реализации OLAP-функциональности.

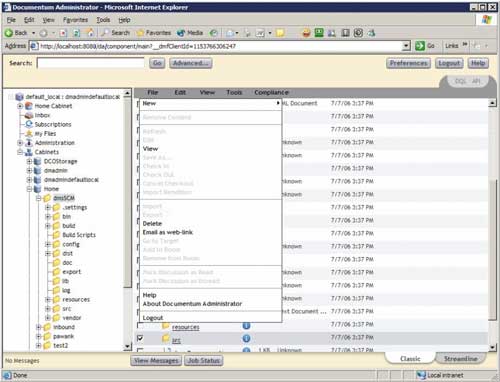

Утилита администрирования средства управления

информационным наполнением Documentum

Linux как платформа для СУБД

Linux как платформа для СУБД используется достаточно давно, но в последнее время интерес к подобному применению этой платформы заметно возрос благодаря серьезным вложениям в него со стороны производителей СУБД (Oracle, IBM, Sybase, Teradata) и поставщиков аппаратно-программных решений (Dell, HP, IBM), выразившимся в появлении на рынке широкого спектра протестированных и сертифицированных серверных конфигураций на основе Linux для конкретных СУБД.

Одной из основных причин использования Linux как платформы для СУБД является относительно невысокая совокупная стоимость владения подобными серверами по сравнению с Windows- и UNIX-платформами. В условиях экономического кризиса интерес к Linux как к платформе для СУБД может возрасти, поскольку ее применение снижает стоимость внедрения решений, основанных на применении СУБД, однако рост может оказаться не слишком заметным вследствие затрат на персонал, обладающий навыками администрирования подобных решений.

Управление информационными активами предприятия

Управление информационными активами предприятия (Enterprise Information Management) представляет собой структурирование, описание и сопровождение информации, принадлежащей компании независимо от технологической реализации ее хранения с целью повышения эффективности деятельности компании. Сегодня многие компании испытывают проблемы с поиском и применением уже имеющейся у них информации, что крайне негативно отражается на эффективности их работы.

Отметим, что хотя производители программного обеспечения нередко используют термин «управление информационными активами предприятия» в маркетинговых целях, реальное осуществление подобного управления требует не столько внедрения какого-либо продукта, сколько выполнения комплекса мероприятий и создания и соблюдения определенных правил (что, тем не менее, не исключает применения каких-либо продуктов и технологий). В условиях экономического кризиса интерес к управлению информационными активами может возрасти, поскольку массовое сокращение персонала в компаниях несет риск утраты части знаний и компетенций.

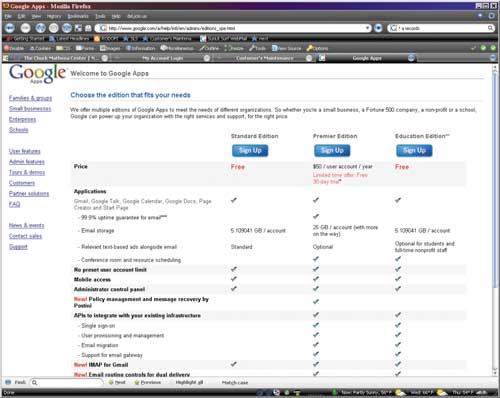

Google Apps

Управление информационным наполнением

Управление информационным наполнением (Enterprise Content Management, ECM) — это комплекс мероприятий, направленный на организацию хранения, доступа и применения неструктурированного информационного наполнения (документов, изображений, мультимедиаданных, форм и т.д.). Для решения подобных задач на рынке имеется немало инструментов, однако их внедрение обычно сопряжено с организационными сложностями, такими как конфликты интересов разных потребителей контента, проблемы с правами на те или иные данные, а также проблемы организации соответствующей инфраструктуры.

В условиях экономического кризиса интерес к управлению информационным наполнением может снизиться, поскольку проекты внедрения подобных решений обычно оказываются весьма дорогостоящими.

Средства повышения эффективности работы и поддержки принятия решений

Технологии поиска в медиаданных

Поиск в медиаданных (Rich-Media Search) предполагает индексирование аудио- и видеоданных, доступных в Интернете, в базах данных и в файловой системе, либо с применением связанных с этими данными специальных тэгов, либо с помощью анализа самих данных. Пока используемые для решения этой задачи технологии недостаточно развиты, однако в некоторые из них, таких как распознавание речи, поиск субтитров в видеоданных и поиск в web-страницах, вкладываются немалые средства, поскольку эти технологии могут стать факторами успеха поисковых и мультимедийных порталов. В последнее время такие технологии развиваются довольно активно, и маловероятно, что экономический кризис существенно повлияет на их развитие.

Открытые форматы офисных документов (Open XML, OpenDocument)

Office Open XML File Formats (OOXML) — открытая спецификация формата документов, основанного на применении XML и используемого в приложениях семейства Microsoft Office 2007. Open Document Format for Office Applications (стандарт ISO/IEC 26300) — это открытая спецификация формата офисных документов, разработанная сообществом OpenOffice.org. В настоящее время рядом компаний, включая Microsoft и Novell, ведутся работы по обеспечению совместимости форматов и созданию конверторов между форматами, и многие компании производят библиотеки для создания решений, включающих генерацию документов обоих форматов. Влияние указанных спецификаций на будущее развитие офисных приложений и других решений очень высоко, и, учитывая огромную популярность Microsoft Office в нашей стране, в ближайшее время следует ожидать широкого распространения OOXML. Воздействие экономического кризиса на этот процесс представляется минимальным.

Офисные пакеты на основе Web 2.0

Офисные пакеты на основе Web 2.0 (Web 2.0 Office Productivity Suites) — это наборы приложений для решения таких задач, как подготовка документов, работа с электронными таблицами, создание презентаций, организация коллективной работы и обмена почтовыми сообщениями. Обычно для этой цели применяются настольные приложения, такие как продукты семейств Microsoft Office, Corel WordPerfect, OpenOffice.org. Пакеты на основе Web 2.0 представляют собой веб-приложения, обеспечивающие сходную функциональность. Подобные приложения стали доступны в течение последних нескольких месяцев; впрочем, на данный момент они отнюдь не дублируют функциональность настольных офисных приложений, а скорее позволяют решать более узкие задачи. Одна из самых популярных реализаций данной технологии — Google Apps.

Хотя указанные технологии приобретают определенную популярность, не стоит ожидать ни вытеснения ими настольных приложений еще как минимум в течение нескольких лет, ни какого бы то ни было влияния экономического кризиса на этот процесс.

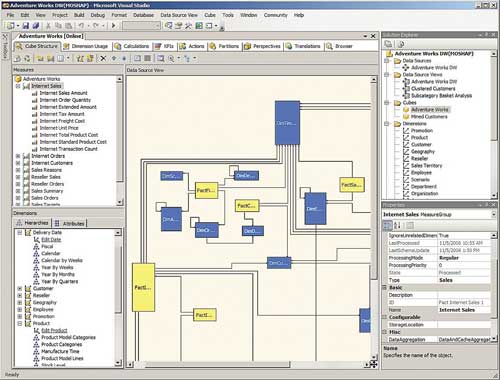

Платформы для бизнес-анализа

Платформы для бизнес-анализа (Business Intelligence Platforms) представляют собой основу для построения аналитических приложений, включающих онлайновую аналитическую обработку данных, их анализ, представление результатов анализа в виде отчетов и информационных панелей, интеграцию с другими приложениями. Сегодня на рынке доступны платформы бизнес-анализа многих известных производителей, таких как Business Objects, Hyperion, Microsoft, Oracle, SAP, SAS, а также множество решений на их основе для различных отраслей, однако эта область продолжает быстро развиваться под влиянием новых технологий и концепций.

На развитие самих платформ бизнес-анализа экономический кризис вряд ли окажет заметное влияние, по крайней мере в ближайшие годы. Однако проектов по внедрению решений на их основе станет, видимо, гораздо меньше.

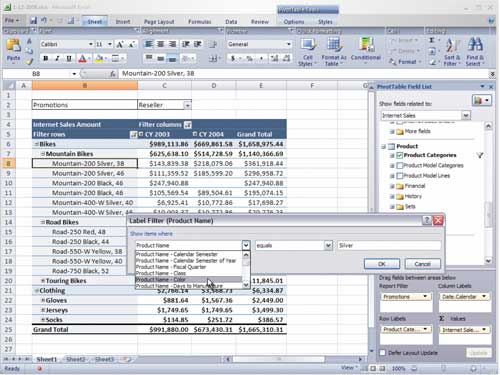

Excel как клиентская часть аналитических приложений

Будучи одним из самых популярных офисных приложений, Excel сегодня привлекает пристальное внимание производителей средств и платформ бизнес-анализа как универсальное клиентское средство представления и анализа данных. Большинство поставщиков подобных платформ предоставляют дополнительные модули для Excel, предназначенные для отображения и анализа данных, доступных с помощью этих платформ.

Платформа бизнес-анализа на основе аналитических служб SQL Server

Выход Excel 2007, появление служб Excel Services, а также выпуск средства анализа данных PerformancePoint Server во многом способствовали росту применения Excel как составной части аналитических решений и качественного изменения принципов анализа данных во многих компаниях.

Excel как клиентская часть аналитического приложения на основе SQL Server

Учитывая огромную популярность Excel и относительно невысокую стоимость решений на его основе, следует ожидать роста интереса к этому продукту как к клиентской части аналитических приложений в качестве альтернативы более дорогим решениям.

Программное обеспечение для информационной безопасности

Управление цифровыми правами

Управление цифровыми правами в корпоративном секторе (Digital Rights Management, DRM) — это предотвращение неавторизованного доступа к данным, содержащимся в документах, путем запрета их просмотра, копирования, редактирования, печати и отправки по электронной почте. Подобные технологии стали доступны в 2003 году, после появления их первых реализаций от Microsoft и Adobe. Сегодня службы Microsoft Rights Management Services поддерживаются операционными системами Windows Server 2003, Windows Server 2008, Windows XP Professional и Windows Vista. Тем не менее в корпоративном секторе в ближайшие годы не следует ожидать активного массового использования подобных технологий, и экономический кризис вряд ли существенно повлияет на этот процесс.

Управление цифровыми правами на рынке приложений для домашнего применения заключается в запрете от неавторизованного использования данных, защищенных авторскими правами (таких как музыкальные произведения, книги и журналы). В отличие от корпоративного сектора, на рынке приложений для домашних пользователей подобные технологии (такие, например, как FairPlay DRM от компании Apple, предназначенные для пользователей службы iTunes, а также технологии аналогичного назначения компаний Macrovision, Microsoft, Sony) применяются весьма активно. Впрочем, объемы продаж защищенного цифрового контента в условиях экономического кризиса могут снизиться.

Управление идентификацией

Распределенное управление идентификацией (Federated Identity Management) позволяет использовать общие идентификационные данные для доступа к разным серверам, службам и доменам благодаря обмену идентификационными сведениями между ними. Сегодня с появлением таких технологий, как Security Assertion Markup Language (SAML) и Active Directory Federation Services (ADFS), а также сходных по назначению технологий компаний Computer Associates, EMC, HP, IBM, Novell, Oracle, Sun Microsystems и Microsoft, к ним проявляют интерес многие компании, в особенности территориально распределенные предприятия с большим количеством удаленных пользователей или с подразделениями, способными функционировать самостоятельно. В последнее время также наблюдается тенденция аутсорсинга служб управления идентификацией и применение технологий под общим названием claims-based access — доступ по требованию. Маловероятно, что экономический кризис повлияет на развитие этого направления.

Доступ с помощью единой «точки входа»

Доступ с помощью единой «точки входа» (Enterprise Single Sign-On) — это возможность доступа к различным информационным системам, ресурсам и приложениям путем однократной идентификации. Средства обеспечения подобного способа доступа применяются довольно активно, поскольку во многих компаниях они значительно уменьшают стоимость обслуживания пользователей за счет снижения количества обращений в службы технической поддержки, а также повышают эффективность работы самих пользователей. Маловероятно, что экономический кризис затронет развитие этого направления.

Мониторинг и предотвращение активности приложений

Технологии мониторинга и предотвращения активности приложений (Application Activity Monitoring and Prevention), такие как взаимодействие с пользователем, выполнение транзакций и т.д., предназначены для выявления и предотвращения подозрительных действий, не соответствующих политике безопасности. Эти технологии основаны на широко известных технологиях перехвата сетевого трафика, применяемых совместно с методами анализа, используемыми в ряде аналитических платформ. В настоящее время наблюдается бурный рост интереса к подобных технологиям, в первую очередь за счет активного рыночного спроса на них, и в условиях кризиса он может увеличиться вследствие роста криминальной активности в Интернете.

Управление доступом к сети

Процесс управления доступом к сети (Network Access Control) предназначен для проверки состояния безопасности подключаемого к сети устройства, мониторинга уже подключенных устройств и генерации политик безопасности по отношению к устройствам на основе их состояния. Технология находится на этапе восхода надежд — уже есть ее первые промышленные реализации, такие как Cisco NAC, и в силу интереса к ней корпоративных заказчиков она может достичь пика завышенных ожиданий довольно быстро. Влияние кризиса на развитие этих технологий не должно быть существенным.

Программное обеспечение с открытым кодом

Серверы приложений Java EE с открытым кодом (Open-Source Java EE Application Servers)

К серверам приложений Java EE с открытым кодом (Open-Source Java EE Application Servers) относятся серверы приложений, прошедшие тест на совместимость с требованиями спецификации Java 2 Enterprise Edition и распространяемые по лицензии OpenSource. В настоящий момент эти серверы представляют собой весьма серьезную альтернативу коммерческим серверным платформам, как поддерживающим спецификацию J2EE, так и основанным на других технологиях, например Microsoft .NET, Zend PHP и Adobe ColdFusion. Из серверов приложений Java EE с открытым кодом сегодня широко применяются Red Hat JBoss и Apache Tomcat, однако это не единственные доступные продукты подобного класса.

Интерес к подобным технологиям в условиях кризиса может возрасти за счет невысокой стоимости внедрения решений на основе подобных серверов.

Серверные операционные системы с открытым кодом

Серверные операционные системы с открытым кодом представляют собой свободно распространяемое программное обеспечение, вследствие доступности исходного кода постоянно совершенствуемое сообществом разработчиков. Из наиболее известных операционных систем подобного класса следует отметить GNU/Linux (дистрибутивы компаний Red Hat, Novell, Oracle, Ubuntu и ряда других производителей), FreeBSD, OpenSolaris, OpenBSD и NetBSD. Благодаря участию в создании и поддержке подобных операционных систем лидеров рынка программного обеспечения, таких как Novell, Oracle, HP, IBM, SGI и Unisys, сейчас они широко применяются в качестве серверных платформ для кластерных СУБД, веб-приложений, корпоративных серверов приложений и файловых серверов на различных аппаратных платформах. Интерес к подобным технологиям в условиях кризиса может возрасти за счет невысокой стоимости внедрения решений на основе подобных серверов.

Apache Tomcat Application Server

Linux как серверная платформа

Linux представляет собой одну из самых популярных операционных систем с открытым кодом. Во многих компаниях эта операционная система используется в качестве файловых серверов и серверов печати как альтернатива NetWare или Windows. Помимо этого Linux нередко применяется как платформа для серверных СУБД, веб-приложений, J2EE-решений, в том числе для приложений с высокими требованиями к надежности и доступности — возможность подобного применения, в том числе на кластерах серверов, подтверждается многочисленными результатами независимого тестирования. Интерес к данной операционной системе в условиях кризиса может возрасти за счет невысокой стоимости внедрения решений с применением серверных версий Linux, однако этот рост может оказаться не слишком значительным из-за затрат на персонал, имеющий навыки администрирования подобных решений.

Linux как корпоративная настольная ОС

Будучи весьма популярной в качестве серверной платформы, Linux как настольная ОС используется редко. Тем не менее низкая совокупная стоимость владения рабочими местами на основе Linux может сделать эту платформу привлекательной в тех случаях, когда потребность в применении Windows-приложений на рабочих местах пользователей ограничена, а необходимость миграции с Windows-платформ отсутствует (например, для автоматизации ранее неавтоматизированной деятельности). Интерес к данной операционной системе в условиях кризиса может возрасти за счет низкой стоимости внедрения решений на ее основе.

Ubuntu Linux

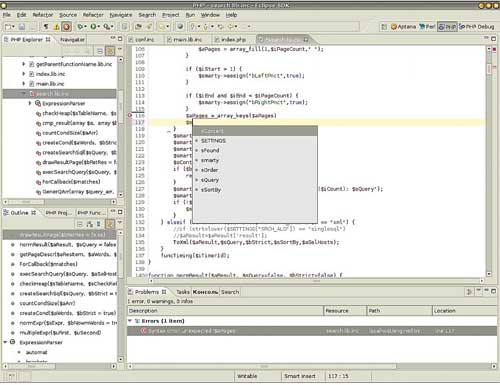

Средства разработки с открытым кодом (Open-source application development tools)

Средства разработки с открытым кодом, а именно инструменты для проектирования, создания, тестирования и отладки приложений, существуют много лет. Однако если несколько лет назад подобные средства в основном представляли собой инструменты для решения небольших специализированных задач (компиляторы, отладчики и пр.), то сегодня среди подобных инструментов существуют комплексные среды разработки, не уступающие по своим возможностям коммерческим продуктам.

Среда разработки Eclipse

Наибольшее влияние на развитие рынка подобных инструментов оказал проект Eclipse, результатом которого стала расширяемая многофункциональная среда разработки для создания распределенных приложений, используемая не только разработчиками, но и многими производителями коммерческих инструментов в качестве основы их продуктов.

Помимо Eclipse из средств разработки с открытым кодом популярна также среда NetBeans. Хотя средства моделирования и тестирования с открытым кодом пока еще не столь развиты, как средства создания приложений, следует ожидать расширения сферы применения всех категорий инструментов с открытым кодом, хотя влияние кризиса на этот процесс представляется минимальным.

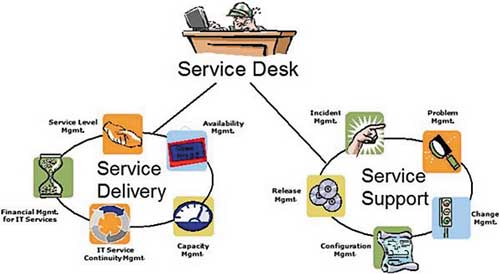

Управление предоставлением ИТ-услуг

Такая область, как управление предоставлением ИТ-услуг, включает методологии подобного управления, а также программное обеспечение для его поддержки. ITIL и CobiT, например, по сути представляют собой не что иное, как наборы рекомендаций, планов действий и организационных мер. Однако актуальность их достаточно высока вследствие неплохих эффектов от внедрения и применения во многих компаниях.

CobiT

Control Objectives for information and related Technology (CobiT) — набор процессов для формирования целей ИТ и аудита ИT-услуг с целью проверки их соответствия требованиям компании. Позволяет сформировать критерии оценки эффективности оказания ИТ-услуг и деятельности ИТ-подразделений и внешних компаний, оказывающих ИТ-услуги применительно к достижению целей основного бизнеса компании. Влияние кризиса на применение CobiT представляется минимальным, хотя проекты внедрения этих процессов в период кризиса будут реализовываться в компаниях скорее своими силами, нежели силами консалтинговых компаний.

Information Technology Infrastructure Library

Information Technology Infrastructure Library (ITIL) — библиотека передового опыта оказания ИТ-услуг, содержащая подробное описание наиболее важных процессов и видов деятельности в работе ИТ-подразделения, а также полный перечень сфер ответственности, задач, процедур, описаний процессов и списков действий, которые могут быть адаптированы для любой организации.

Рекомендации ITIL применяются во многих крупных компаниях, поскольку позволяют упорядочить и формализовать взаимодействие между поставщиками и потребителями ИТ-услуг. Впрочем, пик интереса к ITIL уже прошел, и данное направление движется к впадине разочарований. Причиной тому является то, что рекомендации ITIL уже учтены во многих продуктах для управления ИТ-инфраструктурой (HP OpenView, IBM Tivoli и др.) и именно к реализациям идей ITIL и конкретным проектам внедрения подобного ПО интерес заказчиков оказывается гораздо выше, нежели к самой библиотеке ITIL. Влияние кризиса на интерес к ITIL представляется минимальным.

Средства управления портфелями ИТ-услуг

Средства управления портфелями ИТ-услуг (IT Service Portfolio Management Tools) предназначены для каталогизации стандартизованных ИТ-услуг и поддерживающих их архитектур, контрактов с поставщиками ИТ-услуг, автоматизации потоков работ, связанных с их предоставлением. Кроме того, они могут включать функциональность средств управления информационными активами и средств категории Service Desk. Рост интереса к подобным средствам обусловлен тем, что в условиях роста популярности аутсорсинга ИТ-услуг данная категория ПО, будучи еще одной реализацией идей ITIL, позволит обеспечить поддержку процессов ITIL, не требуя внедрения избыточных и дорогостоящих решений по управлению всей инфраструктурой, что может оказаться интересным для широкого круга компаний, не работающих в ИТ-сфере и не имеющих собственной развитой ИТ-инфраструктуры, но пользующихся ИТ-услугами других организаций.

Процессы ITIL

Интерес к подобным услугам в условиях кризиса может возрасти за счет возможности снизить затраты на собственную ИТ-инфраструктуру.

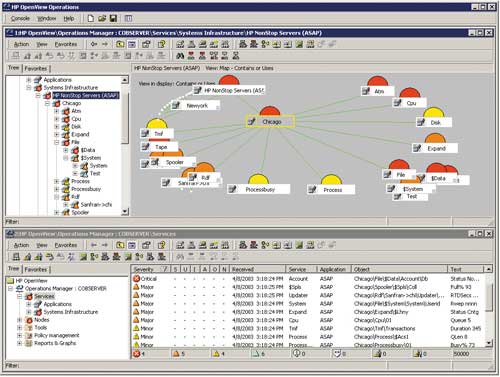

Управление приложениями

Управление приложениями (Application Management) — это управление производительностью, доступностью, конфигурациями приложений, основанных на различных технологиях и платформах. Рост интереса к данному виду инфраструктурного ПО обусловлен усложнением ИТ-инфраструктуры многих компаний и возросшими требованиями к его поддержке, своевременному обновлению, безопасности и совместимости различных компонентов. На данный момент имеется достаточное количество решений подобного класса от HP, IBM, Microsoft, BMC и других компаний, и пик интереса к ним уже близок. Тем не менее интерес к внедрению подобных средств в период кризиса может снизиться, поскольку проекты их внедрения, как правило, весьма дорогостоящие.

Управление приложениями с помощью

HP OpenView Operations Manager

Web-технологии

Web-технологии — одно из самых быстроразвивающихся семейств технологий с быстро расширяющейся сферой применения. К наиболее интересным в плане влияния на всю индустрию технологий данного класса, относящихся к области корпоративного ПО, следует причислить ряд идей под общим названием AJAX, касающихся создания веб-приложений, а также продукты для разработки корпоративных веб-решений путем внедрения готовых приложений для создания корпоративных и интернет-порталов.

AJAX

AJAX (Asynchronous JavaScript and XML) — это принцип создания веб-приложений, заключающийся в том, что нет необходимости в полной перезагрузке веб-страницы в ответ на каждое действие пользователя — с веб-сервера догружаются только нужные пользователю данные. Этот принцип реализуется путем генерации на сервере динамического HTML и соответствующего кода на скриптовых языках для выполнения в клиентском приложении с помощью большинства доступных сегодня серверных технологий (PHP, ASP .NET 2.0, Ruby on Rails и пр.). Сегодня он применяется во многих средствах разработки. Влияние кризиса на развитие этого направления представляется минимальным.

Mashup

Mashup — это интеграция информации, полученной из разных источников, с помощью быстро создаваемых простых приложений, основанных на клиентских или серверных веб-технологиях. Подобный способ создания приложений позволяет значительно снизить стоимость разработки веб-приложений за счет использования уже готовых сервисов, доступных на рынке онлайновых услуг (таких как Google Maps или сходные по назначению отечественные сервисы, оглавления новостных сайтов, сведения о курсах валют).

Пример использования Mashup

Хотя подобные приложения серьезно зависят от надежности используемых в них компонентов и сервисов, интерес к ним быстро растет, и в ближайшие годы следует ожидать широкого применения подобных технологий, в том числе с использованием средств персонализации, а также увеличения количества повторно применяемых сервисов. Влияние кризиса на развитие этого направления представляется минимальным.

Корпоративные порталы

Портал — это набор инфраструктурных веб-приложений для персонализованного доступа к информационным активам предприятия (данным, документам, бизнес-приложениям). Это направление находится в стадии подъема жизнестойкости: будучи популярным на рынке корпоративного ПО уже несколько лет, оно неуклонно движется к плато продуктивности за счет того, что корпоративные порталы сегодня внедряют даже небольшие компании, а на рынке ПО предлагается много разнообразных решений для их быстрого развертывания, а также достаточно поставщиков соответствующих услуг. Хотя в условиях кризиса развитие корпоративных порталов в ряде компаний может на какое-то время замедлиться, в целом влияние кризиса на развитие этого направления представляется незначительным.

Управление информационным наполнением веб-сайтов

Управление информационным наполнением веб-сайтов (Web Content Management) осуществляется с помощью специализированных средств. В большинстве случаев средства управления информационным наполнением веб-сайтов и веб-порталов позволяют осуществлять централизованное управление хранимыми данными (чаще всего фрагментами документов) и их изменением, отделение содержания от представления (то есть от дизайна сайта), автоматизацию управления жизненным циклом данных и связанных с ними потоками работ, применение их разными пользователями для решения различных задач. В условиях кризиса компании будут отдавать предпочтение тем решениям, стоимость внедрения и сопровождения которых минимальна.

Электронные дисплеи

Дисплеи, проецирующие изображение на сетчатку

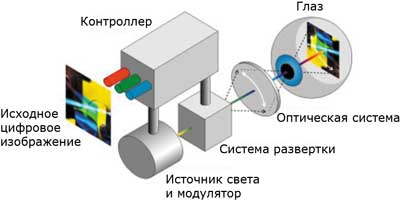

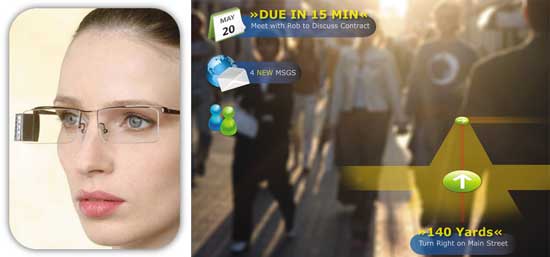

Аппараты, позволяющие при помощи лазерного луча малой мощности проецировать изображение непосредственно на сетчатку глаза (Virtual Retinal Display, VRD), являются одним из перспективных направлений развития электронных дисплеев, особенно применительно к использованию в мобильных устройствах. Благодаря небольшим размерам и отсутствию громоздкого экрана, VRD-проектор можно встраивать в одежду и специальную экипировку (очки, шлемы и т.д.). Кроме того, важным преимуществом данной технологии является возможность проецировать изображение, угловые размеры которого практически целиком охватывают угол зрения.

Изображение в VRD-устройствах формируется последовательно (пиксел за пикселом) при помощи устройства развертки: луч лазера с большой скоростью «прорисовывает» строки пикселов изображения аналогично тому, как это происходит в лазерном принтере. Один из первых прототипов монохромного VRD-дисплея был создан сотрудниками лаборатории пользовательского интерфейса Вашингтонского университета в 1991 году.

Принцип работы цветного VRD-дисплея

На современном этапе технически возможно создание VRD-дисплеев, проецирующих монохромные и цветные изображения с разрешающей способностью порядка 800x600 пикселов. Для формирования цветного изображения используются три лазера (красный, зеленый и синий), лучи которых совмещаются при помощи специальной оптической системы. В настоящее время модули VRD-дисплеев, в которых применяются полупроводниковые лазеры и устройство развертки с микроэлектромеханическим приводом (MEMS), выпускает компания Microvision.

Размеры модуля VRD-дисплея позволяют встраивать его в очки

По мнению экспертов, полноценное применение данной технологии в коммерческих устройствах станет возможным при достижении уровня разрешающей способности порядка 4000x3000-8000x6000 пикселов.

OLED- и LEP-дисплеи

OLED и LEP — родственные технологии, позволяющие создавать излучающие электронные дисплеи на базе люминесцирующих материалов.

OLED (Organic Light Emitting Diode) — это светодиоды на основе органических материалов. Первыми проводить исследования в данной области начали в конце 80-х годов прошлого века сотрудники компании Eastman Kodak.

LEP (Light Emitting Polymer) — это светоизлучающие полимеры, впервые синтезированные учеными Кембриджского университета. Впоследствии разработками в данном направлении стала заниматься компания Cambridge Display Technology.

Принципиальное отличие OLED- и LEP-дисплеев от устройств на базе ЖК-технологии заключается в использовании органических веществ, излучающих свет под воздействием электрического поля (в ЖК-дисплеях свет, излучаемый лампой подсветки, проходит через ячейки ЖК-матрицы и светофильтры). Благодаря этой особенности в OLED- и LEP-дисплеях нет необходимости применять лампу подсветки, поляризующие пленки и ряд других компонентов, являющихся обязательными элементами ЖК-устройств. За счет более простой структуры OLED-дисплеи можно сделать чрезвычайно тонким и легкими. Кроме того, они могут работать от меньшего (по сравнению с ЖК-панелями) напряжения, обладают низким уровнем энергопотребления и выделяют незначительное количество тепла.

Схема устройства OLED-дисплея

По качеству изображения OLED-технология также превосходит ЖК, обеспечивая более высокие яркость и контрастность, а также очень большой эффективный угол обзора (до 180° как в горизонтальной, так и в вертикальной плоскости) без заметных искажений цветопередачи. При этом полноцветные OLED-дисплеи имеют цветовой охват на уровне хороших ЭЛТ-мониторов и обеспечивают гораздо более точное воспроизведение цветов, чем современные модели ЖК-мониторов.

Использование люминесцирующих материалов в перспективе позволит сделать апертуру пиксела OLED-дисплея практически равной 1 (то есть эффективная площадь пиксела будет равна его полной площади), что в принципе невозможно в случае ЖК-технологии. Дополнительным преимуществом OLED-дисплеев является чрезвычайно малое время реакции пикселов (у существующих прототипов — порядка десятков микросекунд), причем практически не зависящее от температуры (в отличие от ЖК-дисплеев, OLED- и LEP-устройства не «замерзают» при низкой температуре).

Прототипы цветных OLED-дисплеев

OLED-технология особенно привлекательна для создания дисплеев небольшого размера, поскольку имеет значительно более высокий (по сравнению с ЖК) потенциал для увеличения разрешающей способности (на нынешнем этапе — до нескольких сотен пикселов на дюйм).

В настоящее время на базе технологий OLED и LEP технически возможно создание монохромных, многоцветных и полноцветных дисплеев с активной либо пассивной матрицей.

У OLED- и LEP-дисплеев есть ряд недостатков, которые пока ограничивают сферу их применения в серийно выпускаемых устройствах. В частности, органические молекулярные и полимерные светоизлучающие материалы быстро разрушаются под воздействием содержащегося в воздухе кислорода и водяных паров, поэтому для обеспечения приемлемой (с точки зрения коммерческого использования) долговечности необходима полная герметизация начинки дисплейной панели. Кроме того, органические светоизлучающие материалы постепенно деградируют в процессе работы — это проявляется в уменьшении их эффективности (падении яркости при заданном напряжении питания) и изменении спектральных характеристик. Одним из наиболее актуальных на данный момент направлений работы в области совершенствования OLED- и LEP-дисплеев является создание более долговечных излучающих материалов.

В настоящее время OLED-дисплеи небольшого размера широко применяются

в портативных электронных устройствах

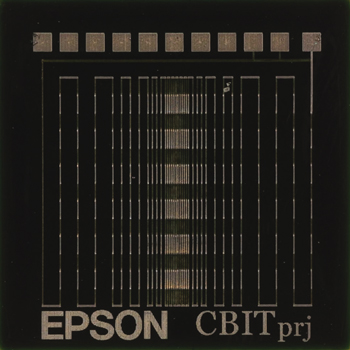

Работы в области создания и производства OLED- и LEP-дисплеев, а также оптимизации характеристик органических светоизлучающих материалов в настоящее время ведут компании Cambridge Display Technologies (CDT), DuPont, Eastman Kodak, LG Electronics, Philips, Pioneer, RiTdisplay, Samsung SDI, Sanyo Epson Imaging Device Corporation, Sony, Toshiba и Universal Display Corporation.

В настоящее время OLED- и LEP-дисплеи небольших размеров используются в целом ряде моделей серийно выпускаемых электронных устройств, таких как автомагнитолы, портативные медиаплееры, сотовые телефоны и пр. В 2008 году были выпущены и первые коммерческие продукты с OLED-дисплеями среднего размера, предназначенные для стационарного применения. Так, в начале минувшего года компания Sony анонсировала первый в мире серийно выпускаемый телевизор, оснащенный OLED-панелью (модель XEL-1). Экранный модуль этого телевизора обеспечивает превосходное качество изображения и широкий угол обзора, а его толщина составляет всего 3 мм. На проходившей в сентябре выставке Photokina 2008 компания Eastman Kodak представила первую серийную модель цифровой фоторамки, оснащенную OLED-панелью с экраном 7,6 дюйма по диагонали и разрешением 800x480 пикселов. Таким образом, сфера применения OLED-дисплеев в серийно выпускаемых устройствах постепенно расширяется.

Sony XEL-1 — первый в мире серийно

выпускаемый телевизор, оснащенный

OLED-дисплеем

На выставках производители показывали и перспективные прототипы с большим размером экрана. Так, на проходившем в октябре минувшего года в Южной Корее форуме International Meeting on Information Display 2008 (IMID) компания Samsung продемонстрировала целый ряд прототипов на базе OLED, в том числе полноразмерные дисплеи для ПК с диагональю экрана 14 и 31 дюйм (последний — с разрешением Full HD), а также 5-дюймовый дисплей для мобильных устройств, имеющий разрешение 848x480 пикселов.

Цифровая фоторамка компании Kodak,

оснащенная 7,6-дюймовым OLED-дисплеем

Согласно предварительным прогнозам, серийные модели дисплейных панелей и телевизоров на базе OLED с размером экрана 30 дюймов и более появятся в продаже в 2011-2012 годах. Нельзя не отметить, что в последнее время аналитики стали более осторожными в оценках перспектив OLED-дисплеев и их соперничества с устройствами на базе ЖК-технологии. Хотя у OLED-дисплеев имеется ряд важных преимуществ над ЖК-панелями, рыночные позиции последних в 2007-2008 годах значительно укрепились благодаря как улучшению их характеристик (что обусловлено совершенствованием технологий их производства), так и постоянному снижению цен. В итоге некоторые производители, ранее сообщавшие о намерении развернуть серийное производство устройств на базе OLED-дисплеев, отказались от этих планов. В качестве примера можно привести действия компании Toshiba, которая в середине 2007 года объявила о намерении начать выпуск телевизоров на базе OLED-дисплеев в 2009-2010 годах, но спустя всего несколько месяцев после анонса поставила на этом проекте крест.

3D-дисплеи на базе ЖК

К настоящему моменту разработано несколько технологий производства дисплеев, создающих у наблюдателя правдоподобную иллюзию объемного (трехмерного) цветного изображения без применения вспомогательных средств (очков и пр.).

Нужного эффекта можно достичь, оснастив обычный ЖК-дисплей так называемым параллакс-барьером (например, пленкой с чередующимися непрозрачными вертикальными полосками и узкими прозрачными зазорами между ними). Если шаг полосок параллакс-барьера равен ширине двух пикселов, то при отклонении в одну сторону от осевой линии монитора наблюдатель сможет видеть только четные столбцы пикселов, а при отклонении в другую — нечетные. Изменяя расстояние между экраном монитора и параллакс-барьером, можно добиться того, чтобы правый глаз наблюдателя воспринимал изображение, сформированное нечетными столбцами пикселов, а левый — четными. Если вывести на экран такого монитора специальным образом подготовленную стереограмму (в которой будут перемежаться столбцы пикселов изображений левого и правого ракурсов), то у зрителя возникнет иллюзия трехмерности.

Принцип действия параллакс-барьера, расположенного

с внешней стороны дисплейной панели

Принцип действия активного параллакс-барьера между ЖК-панелью и лампой подсветки

Параллакс-барьер может быть как пассивным (пленка с непрозрачными полосками), так и активным элементом (монохромная ЖК-панель). В последнем случае монитор можно сделать универсальным: с выключенным параллакс-барьером он будет работать в обычном, двумерном режиме, а при активации параллакс-барьера — в трехмерном.

Несколько лет назад специалисты Philips Research Redhill разработали собственный вариант конструкции 3D-монитора на базе ЖК-панели, в котором вместо параллакс-барьера используется массив миниатюрных цилиндрических линз.

В настоящее время исследования в области создания 3D-дисплеев на базе ЖК-технологии ведут компании Eastman Kodak, Hitachi, NEC, Philips, Samsung, Sanyo, Sharp и Toshiba.

На данный момент 3D-дисплеи на базе ЖК-технологии находятся на начальной стадии коммерциализации. Решения, позволяющие пользователю наблюдать объемное цветное изображение без вспомогательных средств (специальных очков и т.п.), уже реализованы в ряде серийно выпускаемых ЖК-дисплеев компаний NEC, Philips, Sharp и ряда других. Правда, сфера применения подобных устройств пока остается довольно ограниченной — они используются главным образом для показа рекламных материалов в крупных торговых центрах. Одной из основных проблем, препятствующих широкому распространению 3D-мониторов, является отсутствие простых в применении и при этом недорогих программных средств, позволяющих создавать изображения и видео в трехмерном виде.

Одна из серийно выпускаемых дисплейных

ЖК-панелей компании Philips, позволяющая

воспроизводить трехмерные изображения

без применения вспомогательных средств

Определенные надежды производители возлагают на 3D-дисплеи небольшого размера, предназначенные для установки в мобильные телефоны и портативные цифровые медиаплееры. В 2007-2008 годах на различных выставках было продемонстрировано более десятка прототипов ЖК-дисплеев с диагональю экрана от 2 до 3 дюймов, позволяющих воспроизводить объемные цветные изображения. Внедрение таких дисплеев в серийно выпускаемые продукты позволит создать новую рыночную нишу для производителей медиаконтента, в частности стереоскопических изображений и видеороликов.

Электронные чернила (e-ink)

Технология электронных чернил была разработана компаниями E Ink и Philips. В ходе многолетних исследований ученым удалось создать новый тип устройств для отображения информации — электрофоретические отражающие дисплеи. Такие устройства обладают оптическими и механическими характеристиками, схожими с обычной бумагой.

Базовыми элементами электрофоретических дисплеев являются микрокапсулы, диаметр которых не превышает толщину человеческого волоса. Внутри каждой микрокапсулы находится большое количество пигментных частиц двух цветов: положительно заряженные белые и отрицательно заряженные черные, а все внутреннее пространство микрокапсулы заполнено вязкой прозрачной жидкостью.

Принцип работы электрофоретического отражающего дисплея

Слой микрокапсул расположен между двумя рядами взаимно перпендикулярных гибких электродов (сверху — прозрачных, снизу — непрозрачных), образующих адресную сетку. При подаче напряжения на два взаимно перпендикулярных электрода в точке их пересечения возникает электрическое поле, под действием которого в расположенной между ними микрокапсуле группируются пигментные частицы. Частицы с одним зарядом собираются в верхней части микрокапсулы, а с противоположным — в нижней. Для того чтобы поменять цвет точки экрана с белого на черный или наоборот, достаточно изменить полярность напряжения, поданного на соответствующую пару электродов. Таким образом, пиксел экрана, соответствующий данной микрокапсуле, окрасится в черный либо белый цвет; при этом пигментные частицы, сгруппировавшиеся в верхней части микрокапсулы, скроют от наблюдателя все частицы, сосредоточенные в ее нижней части.

Так выглядит изображение на экране электрофоретического дисплея

Дисплеи на базе электронных чернил способны сохранять изображение на экране даже при отсутствии электропитания (подача напряжения на управляющие электроды необходима лишь для переключения состояния пиксела), что наряду с отсутствием лампы подсветки обеспечивает очень низкий уровень энергопотребления. Такие дисплеи являются отражающими и обеспечивают хорошую читаемость изображения практически под любым углом и при любом освещении. В качестве подложки для создания дисплеев на основе электронных чернил можно использовать различные материалы: стекло, пластик, металлическую фольгу, ткань и даже бумагу. Уже созданы прототипы подобных дисплеев на гибкой подложке, способные сохранять работоспособность при сгибании и даже скручивании в рулон.

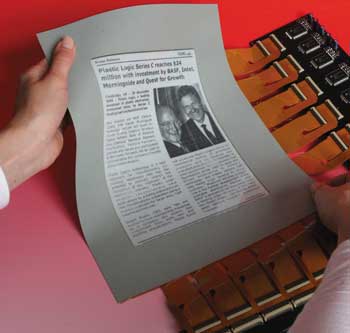

Прототип гибкого дисплея на базе

электронных чернил (фото Plastic Logic)

Основными недостатками дисплеев на базе электронных чернил являются большое время переключения пикселов (0,5-1 с) и ограниченное количество воспроизводимых оттенков (серийно выпускаемые модули позволяют отображать четыре либо 16 оттенков серого).

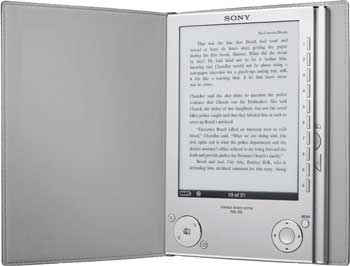

Устройство для чтения электронных книг

Sony Reader PRS-505, оснащенное отражающим

электрофоретическим дисплеем компании E Ink,

доступно в том числе и для российских покупателей

В настоящее время технология электронных чернил, позволяющая создавать монохромные отражающие дисплеи, находится на начальной стадии коммерциализации. Основной сферой применения подобных дисплеев являются устройства для чтения электронных книг. Несколько моделей, оснащенных дисплеями на базе электронных чернил компании E Ink, уже доступны и на российском рынке (подробнее об этом см. в публикации «Устройства для чтения электронных книг» в № 11’2008).

Наручный хронометр Phosphor E Ink Watch

с циферблатом-дисплеем

Есть примеры использования таких дисплеев и в других типах устройств. Так, в 2005 году компания Seiko выпустила наручные электронные часы, оснащенные дисплеем на базе электронных чернил. В конце 2007-го ART Technologies продемонстрировала оригинальный хронометр Phosphor E Ink Watch с циферблатом, представляющим собой круглый дисплей на базе электронных чернил.

Прототипы цветных дисплейных панелей на базе электронных чернил

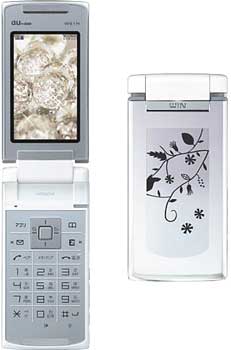

В конце 2006 года компания Motorola представила Motofone F3 — первый в мире мобильный телефон с сегментным дисплеем на базе электронных чернил. В минувшем году была выпущена сотовая трубка Hitachi Mobile W61H с подобным внешним экраном.

Внешний экран мобильного телефона

Hitachi Mobile W61H, созданный на базе

электронных чернил, используется

в качестве оригинального декоративного

элемента (для отображения

сменных узоров)

В настоящее время сразу несколько коллективов исследователей ведут работы по созданию цветных электрофоретических дисплеев. На протяжении последних лет было продемонстрировано несколько работающих прототипов подобных дисплейных панелей (в том числе и созданные на гибкой подложке). Так, на выставке CES 2008 компания LG.Philips продемонстрировала гибкую дисплейную панель толщиной всего 0,3 мм с диагональю экрана 14,3 дюйма, созданную на подложке из металлической фольги. Разрешение этого прототипа составляет 1280x800 пикселов, а цветовая палитра — порядка 16 млн оттенков. В дни проведения форума IMID 2008 компания Samsung продемонстрировала первый в мире цветной активно-матричный электрофоретический дисплей с диагональю экрана 14,3-дюйма, созданный с использованием углеродных нанотрубок. Впрочем, информации о предполагаемых сроках внедрения подобных дисплеев в серийно выпускаемых изделиях пока нет.

Помимо уже упоминавшихся выше компаний E Ink, Samsung и LG.Philips активные работы по совершенствованию электрофоретических дисплеев в настоящее время ведут PVI, Plastic Logic, Polymer Vision, Seiko Epson, Sony и Tianjin Jinke.

Дисплеи на базе бистабильных ЖК-структур (ChLCD и PABN LCD)

По мере роста популярности и многообразия портативных электронных устройств производители проявляют все больший интерес к дисплеям на базе бистабильных ЖК-структур. В отличие от традиционных ЖК-дисплеев, в таких устройствах используются микроструктуры, способные в течение длительного времени находиться в одном из двух устойчивых состояний даже при отсутствии внешнего электрического поля (отсюда и название «бистабильные»). В одном из этих состояний ячейка на основе жидкого кристалла пропускает свет, а в другом — нет. Переключение ячейки из одного состояния в другое осуществляется посредством воздействия внешнего электрического поля, возникающего при подаче напряжения на пару управляющих электродов. Объединив множество бистабильных ячеек в двумерный массив, можно создать дисплей с очень высокой разрешающей способностью (порядка нескольких сотен и даже тысяч пикселов на дюйм).

Монохромная дисплейная панель ChLCD,

выпускаемая компанией LC-TEC Displays

По своим свойствам подобные дисплеи во многом схожи с описанными в предыдущем разделе устройствами на базе электронных чернил. Они обладают очень низким уровнем энергопотребления и способны сохранять изображение на экране при отключении питания. Как и в случае дисплеев на базе электронных чернил, существенным их недостатком является большое (порядка 1 с) время переключения состояния пиксела, что делает невозможным отображение видео. Используя бистабильные ЖК-структуры, можно создавать монохромные и цветные дисплеи — как оснащенные подсветкой, так и без нее.

Начиная с 1993 года работы в области создания дисплеев на базе холестерических жидких кристаллов (Cholesteric Liquid Crystal Display, ChLCD) ведет компания Kent Displays. Технология ChLCD позволяет создавать как монохромные, так и цветные дисплеи различных размеров. Разработкой и производством монохромных дисплейных панелей на базе бистабильных ЖК-структур занимается также шведская компания LC-TEC Displays.

Основная сфера применения монохромных дисплеев с использованием бистабильных ЖК-структур — портативные электронные устройства, а также информационные табло, вывески и т.д.

Прототип цветного дисплея, созданного

по технологии PABN LCD специалистами одной

из лабораторий НР

В настоящее время технология ChLCD находится в стадии коммерциализации — монохромные дисплеи данного типа используются в ряде серийно выпускаемых изделий. Например, во второй половине 2005 года компания A-Data выпустила портативные флэш-накопители, оснащенные небольшими монохромными дисплеями (на которых отображается имя диска и количество оставшегося свободного места), а в числе экспонатов CeBit 2006 была представлена даже SD-карта с дисплеем.

Развитием одной из разновидностей данной технологии, позволяющей создавать цветные дисплеи с высокой разрешающей способностью, занимается группа ученых расположенной в Бристоле (Великобритания) лаборатории НР. Данная технология, получившая название PABN LCD (Post-Aligned Bistable Nematic LCD), уже на нынешнем уровне развития позволяет создавать цветные дисплеи с разрешающей способностью порядка 200-400 ppi (что вполне сопоставимо с детальностью отпечатков цветных лазерных принтеров начального уровня).

Дисплеи на базе технологий SED, FED и NED

Группа из трех родственных технологий — FED (Field Emission Display), SED (Surface-conduction Electron-emitter Display) и NED (Nanotube Emissive Display) — является качественно новой ступенью развития дисплеев на базе электронно-лучевой трубки (ЭЛТ). Как и в случае ЭЛТ, изображение на экранах дисплеев перечисленных типов формируется за счет свечения люминофора, возбуждаемого потоком электронов. Правда, в отличие от ЭЛТ, оснащенной всего тремя электронными пушками, лучи каждой из которых при помощи электромагнитной отклоняющей системы последовательно пробегают по строкам экрана, в SED-дисплеях применяются малогабаритные источники электронов (молибденовые конусы диаметром всего около 200 нм), массивы которых расположены в каждой из ячеек экрана. (В NED-устройствах в качестве источников электронов используются углеродные нанотрубки.)

Принцип работы SED-дисплея

Применение большого количества миниатюрных источников электронов позволяет сделать дисплеи гораздо более тонкими, легкими и экономичными по сравнению с устройствами на базе ЭЛТ. При этом SED-, FED- и NED-дисплеи обладают многими достоинствами систем на базе ЭЛТ: высоким уровнем яркости и контрастности изображения, большим углом обзора, широким цветовым охватом и высокой точностью цветопередачи, а также незначительной инерционностью изображения.

Использование большого количества источников электронов (до нескольких тысяч на каждый пиксел) обеспечивает высокую надежность дисплейных панелей — в отличие от ЖК-мониторов, где выход из строя транзистора, управляющего одним из субпикселов, автоматически означает появление «мертвого» (или залипшего) пиксела на экране.

Определенным недостатком дисплеев рассматриваемых типов является сложность (а следовательно, и дороговизна) их производства. По мнению экспертов, именно по этой причине выпуск таких устройств будет рентабельным лишь при изготовлении панелей с относительно большим размером экрана (50 дюймов и более).

Прототип SED-дисплея Canon

Одной из первых внедрить технологию SED в серийно выпускаемые устройства попыталась компания Canon. В 2005 году было основано совместное предприятие Canon и Toshiba для разработки и производства дисплейных панелей на базе технологии SED, и вскоре публике были показаны первые прототипы. Однако приступить к выпуску SED-дисплеев в конце 2006 года (как это планировалось первоначально) по ряду причин не удалось, а в 2007-м и вовсе наступила черная полоса. Сначала Toshiba, руководство которой разуверилось в перспективах производства SED-дисплеев, продала свою долю в совместном предприятии компании Canon. Затем представители компании Nano-Proprietary (ранее известной под названием Applied Nanotech Holdings) обвинили Canon в нарушении патентов, описывающих конструкцию элементов, которые применяются в SED-дисплеях для формирования потока электронов. Последовали длительные судебные разбирательства. В начале 2008 года Canon сообщила о своем намерении начать разработку нового типа дисплейной панели, работающей по принципу электронной эмиссии, но уже на базе собственной технологии, не затрагивающей патенты компании Nano-Proprietary. Затем американский апелляционный суд все-таки частично признал правоту Canon, и 12 февраля 2008 года японская компания получила измененный патент США на технологию SED. Впрочем, точка в этих разбирательствах еще не поставлена: в декабре минувшего года представители Nano-Proprietary вновь высказали ряд претензий к Canon. Разумеется, все это не способствовало прогрессу в области развертывания серийного производства SED-дисплеев. Кроме того, за период вынужденного простоя цены на ЖК-панели значительно снизились, да и максимальный размер экранов этих устройств заметно увеличился. В течение минувшего года в различных источниках появлялись сообщения о продолжении работ в области создания SED-дисплеев, однако в начале декабря президент компании Canon Цуней Ючида (Tsuneji Uchida) заявил в одном из интервью, что в сложившейся экономической ситуации вывод на рынок продуктов на базе новой технологии был бы неправильным шагом. Таким образом, будущее SED-дисплеев Canon пока под вопросом.

Демонстрация прототипа FED-дисплея в сравнении

с ЖК-дисплеем аналогичного размера

Что касается FED-дисплеев, то их позиция пока выглядит более выигрышной. В конце 2006 года компания Sony и японский технологический фонд Technology Carve-out Investment Fund (TCI) основали предприятие Field Emission Technologies, основным направлением деятельности которого является разработка пригодных к коммерческой эксплуатации FED-дисплеев. Менее чем через год, на выставке CEATEC Japan 2007, представители Field Emission Technologies продемонстрировали работающий прототип 19-дюймового FED-дисплея, имеющего разрешающую способность 1280x960 пикселов и работающего с частотой регенерации 240 кадров в секунду (это позволяет устранить эффект мерцания, присущий телевизорам на базе ЭЛТ). По информации разработчиков, при одинаковой яркости энергопотребление FED-панели оказывается примерно втрое ниже по сравнению с ЖК-дисплеем, имеющим аналогичные размеры и разрешение экрана.

В ноябре 2008 года на одной из выставок Sony показала работающий прототип 19-дюймового FED-дисплея, имеющего разрешение Full HD и позволяющего отображать сигнал с частотой смены кадров до 240 Гц. В качестве источника видеосигнала на демонстрационном стенде были задействованы четыре параллельно работающие игровые консоли Sony PlayStation 3.

Исходя из информации, имеющейся в открытых источниках, уровень развития технологии SED позволяет использовать ее для создания серийных продуктов, однако в силу ряда причин (в том числе экономических) данный проект заморожен на неопределенное время. В свою очередь, технология FED развивается более быстрыми темпами и уже стоит на пороге коммерциализации. Не исключено, что первые серийные продукты на базе FED-панелей появятся в продаже уже в 2009 году. Впрочем, непростая экономическая ситуация может заставить руководство Sony скорректировать свои планы.

LCoS

Технология LCoS (Liquid Crystal on Silicon — жидкие кристаллы на кремнии) была разработана для использования в проекционных устройствах. Центральной частью LCoS-устройства является ЖК-матрица (микродисплей), изготовленная на кремниевой подложке (на ней же расположены и управляющие работой ячеек транзисторы). Однако, в отличие от классической проекционной ЖК-технологии, в данном случае микродисплей работает на отражение. Благодаря этому LCoS-технология обеспечивает ряд преимуществ по сравнению с традиционной ЖК-технологией, в частности пикселы микродисплея LCoS характеризуются меньшим временем реакции, а за счет того, что транзисторы микродисплея расположены под ячейками субпикселов и не препятствуют прохождению света, и значительно большей апертурой.

Принцип работы проекционного устройства на базе LCoS

Исследованиями в области LCoS занимались несколько научных групп. Наибольших успехов в начале нынешнего десятилетия удалось достичь сотрудникам исследовательского отдела компании Philips. Разработчики прочили технологии LCoS массовое применение в недорогих и при этом качественных проекционных устройствах — мультимедиапроекторах и проекционных телевизорах. В перспективе LCoS имеет хорошие шансы стать третьей силой на современном рынке мультимедиапроекторов и потеснить технологии, традиционно используемые в данном типе устройств (речь идет о DLP и 3LCD).

В 2003 году развитием и внедрением LCoS в коммерческие устройства всерьез заинтересовалась корпорация Intel. В январе 2004-го на выставке CES 2004 представители Intel объявили о намерении развивать эту технологию и в ближайшем будущем наладить серийное производство LCoS-чипов для проекционных телевизоров и мультимедиапроекторов. Спустя всего два месяца на весеннем форуме IDF были продемонстрированы работающие прототипы проекционных устройств на базе LCoS-чипов. Согласно первоначальному плану, начало серийного производства LCoS-чипов на мощностях компании Intel было намечено на вторую половину 2004 года. Однако в конце того же года Philips неожиданно объявила об уходе с рынка LCoS-чипов, свертывании всех исследовательских работ в данном направлении и прекращении выпуска соответствующих продуктов. Вскоре компания Intel также объявила о закрытии проекта по развитию технологии LCoS. После этих событий многие производители проекционных устройств утратили интерес к данной технологии, и на некоторое время она оказалась в тени.

Проекционный телевизор серии Sony Bravia,

построенный на базе технологии LCoS

Тем не менее в компаниях Hitachi, Sony и JVC работы по развитию данной технологии были продолжены и впоследствии на рынке появились серийные модели проекционных устройств на базе LCoS. Так, начиная с 2006 года компания Sony производит проекционные телевизоры высокого разрешения на базе LCoS для японского рынка. В 2007 году Sony выпустила первые модели проекторов класса Full HD, построенные на базе технологии SXRD (Silicon X-tal Reflective Display), фактически являющейся фирменной интерпретацией LCoS.

Проектор Sony VPL-VW60 с разрешением Full HD,

построенный на базе технологии LCoS

Стоит отметить, что технология LCoS востребована и в других сегментах. На ее основе можно создавать миниатюрные проекторы (см. раздел «Пикопроекторы»), а также голографические проекционные устройства для визуализации объемных (трехмерных) изображений. Таким образом, в течение ближайших лет можно ожидать повышения интереса разработчиков проекционных устройств различного назначения к технологии LCoS и ее клонам. Тем более что сроки действия патентов на эту технологию истекли и теперь производителям не придется платить лицензионные отчисления за ее использование.

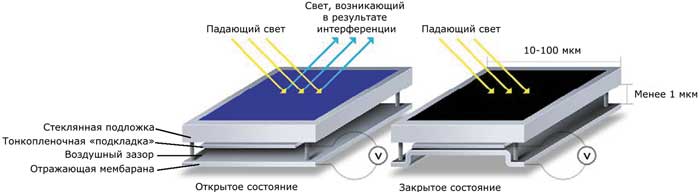

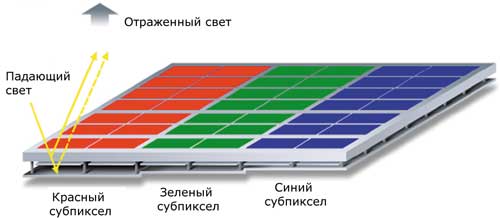

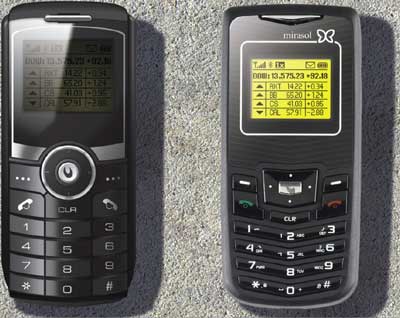

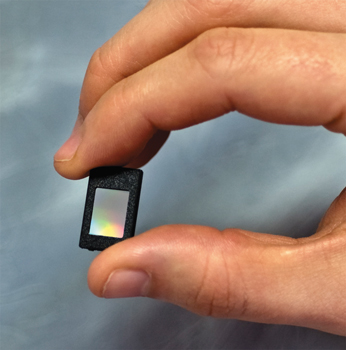

IMOD

В 2006 году в различных СМИ стала появляться информация о работе по созданию принципиально новой технологии электронных дисплеев — Interference Modulator, IMOD. Данная технология базируется на использовании эффекта интерференции световых волн.