Новый лидер среди игровых видеокарт — NVIDIA GeForce GTX580

Компания NVIDIA не могла долго мириться с тем, что первенство на рынке высокопроизводительных видеокарт принадлежит компании AMD с ее двухпроцессорной видеокартой AMD ATI HD5970. После множества фейков и уток компания NVIDIA наконец анонсировала и наладила выпуск главного флагмана новой линейки — видеокарты NVIDIA GeForce GTX580. И вот настал момент, когда новая видеокарта NVIDIA GeForce GTX580 поступила в нашу тестовую лабораторию. В этой статье мы расскажем о ее главных особенностях и, конечно же, результатах тестирования.

У NVIDIA был хороший козырь в виде полноценного графического чипа Fermi, который не был выпущен вслед за анонсом серии видеокарт GTX4x0. Основным флагманом этой линейки являлись видеокарты GeForce GTX480 на базе графического чипа GF100, представляющего собой урезанную версию полноценного графического чипа Fermi. Новые видеокарты GeForce GTX580 основаны на новом графическом процессоре с кодовым названием GF110, который представляет собой полноценную реализацию графического чипа на архитектуре Fermi, которая была анонсирована еще в конце прошлого года. Выпуск же графического чипа GeForce GTX480 был не слишком удачным для компании. Первые видеокарты на базе референсных моделей имели систему охлаждения, которая не справлялась с охлаждением элементов видеокарты. Однако, вопреки ожиданиям и прогнозам, старшая на тот момент модель семейства — NVIDIA GeForce GTX 480 — получила не 512 ядер CUDA, а всего 480. Кроме того, изменения в худшую сторону коснулись и текстурных блоков, количество которых сократилось с заявленных 64 до 60. Без изменений, правда, остались 48 блоков ROP и ширина шины памяти 384 бита.

Новый графический процессор GF110 и видеокарты, построенные на его базе, имеют полный набор ядер CUDA — 512 штук. Графическое ядро GF110 содержит четыре клас-тера GPC, 16 мультипроцессоров SM и шесть 64-битных контроллеров памяти, соединенных с кэшпамятью второго уровня и имеющих по восемь блоков ROP в каждом. Таким образом, 512 потоковых процессоров этого графического чипа находятся в 16 мультипроцессорах по 32 штуки в каждом. В референсной модели видеокарты GTX 580 их количество не занижено искусственно, как это сделано в видеокартах GTX 480, и все мультипроцессоры активны. Подсистема памяти графического ядра осталась без изменений. У каждого мультипроцессора в GF110 64 Кбайт памяти, которая может иметь две различные конфигурации в зависимости от выполняемой задачи: 48 Кбайт общей памяти и 16 Кбайт кэшпамяти L1 или, наоборот, 16 Кбайт общей памяти и 48 Кбайт кэшпамяти первого уровня. Также процессор GF110 снабжен 768 Кбайт унифицированной кэшпамяти второго уровня, которая обслуживает все запросы по загрузке и сохранению данных, а кроме того, текстурные выборки.

В новом графическом процессоре есть пусть небольшие, но актуальные для современных игровых приложений отличия в архитектуре. Как и предшествующий чип среднего ценового диапазона с кодовым названием GF104, новое графическое ядро GF110 умеет обрабатывать текстурные данные, включая билинейную фильтрацию, всех форматов, вплоть до FP16, на полной скорости и без потери тактов. Напомним, что графический чип GF100 не умеет работать в таком режиме, поэтому обработка текстур FP16 у видеокарт GeForce GTX480 теоретически вдвое ниже, чем у видеокарт на базе графических чипов GF104 и GF110. Такое улучшение архитектуры позволяет увеличить производительность рендеринга для многих приложений, например для HDR-рендеринга. Другим усовершенствованием и архитектурным отличием графического чипа GF110 от GF100 является увеличение эффективности алгоритма z-cull, которое также призвано способствовать повышению производительности. Как заявляет компания NVIDIA, согласно ее внутренним тестированиям, архитектурные изменения в новом графическом чипе GF110 в среднем привели к росту производительности рендеринга примерно на 10%, а в некоторых приложениях — на 15%.

Новые графические процессоры GF110 следуют передовым тенденциям в компьютерной графике и поддерживают все современные технологии. Новый графический чип, как и GF110, создается по технологическим нормам 40 нм. Все графические чипы полностью поддерживают последнюю версию API DirectX 11 и Shader Model 5.0. Нельзя обойти вниманием и то, что по сравнению с предыдущим флагманом этой линейки новая модель получила большее количество ядер CUDA, что должно положительно сказаться на скорости выполнения сложных шейдеров. Напомним, что в новых графических адаптерах GeForce GTX 580 поддерживается новая технология под названием NVIDIA Surround, которая является аналогом и ответом на технологию ATI Eyefinity. Новая технология NVIDIA Surround позволяет использовать три монитора одновременно как единое рабочее поле. По сравнению с AMD компания NVIDIA продвинулась в своей версии технологии погружения в виртуальный мир несколько дальше и объединила две технологии — NVIDIA 3D Vision и NVIDIA Surround. Название новой технологии — NVIDIA 3D Vision Surround. Суть объединения заключается в том, что можно одновременно использовать три монитора и очки 3D Vision для создания максимального эффекта присутствия в виртуальном мире. Поскольку технологии 3D в настоящее время переживают настоящий бум, нет сомнений, что NVIDIA 3D Vision Surround станет популярной.

Все новые видеокарты имеют по три различных разъема для подключения мониторов. При этом количество и тип разъемов могут различаться в зависимости от предпочтений производителя видеокарты. Последняя версия драйверов позволяет выставлять различные режимы работы мониторов, включая стандартные режимы клонирования и расширения рабочего стола на несколько мониторов. Как и у AMD, новая технология NVIDIA 3D Vision Surround позволяет пользователю работать как с оконными, так и с полноэкранными 3D-приложениями, применяя при этом очки 3D Vision.

Методика тестирования

Для тестирования видеокарт мы используем тестовый скрипт ComputerPress Game Benchmark Script v.5.0, который позволяет полностью автоматизировать весь процесс тестирования, выбирать игры для тестирования, разрешения экрана, при которых запускаются игры, а также настройки игр на максимальное качество отображения или максимальную производительность, а также задавать количество прогонов для каждой игры.

Методика тестирования видеокарт подробно изложена в статье «Новый игровой бенчмарк ComputerPress Game Benchmark Script v.5.0», опубликованной в апрельском номере журнала, а потому мы не станем повторяться. Отметим, что в этом тестировании в качестве операционной системы мы применяли Windows 7 Ultimate 32 бит, а в качестве стенда — компьютер следующей конфигурации:

- процессор — Intel Core i7 Extreme 965 (тактовая частота 3,2 ГГц, режим Turbo Boost активирован);

- системная плата — Gigabyte EX58-UD4;

- чипсет системной платы — Intel X58 Express;

- память — DDR3-1066 (Qimonda IMSH1GU03A1F1C-10F PC3-8500);

- объем памяти — 3 Гбайт (три модуля по 1024 Мбайт);

- режим работы памяти — DDR3-1066, трехканальный режим;

- тайминги памяти — 7-7-7-20;

- жесткий диск — Western Digital WD3200AAKS.

Для видеокарты устанавливался последний на момент тестирования драйвер NVIDIA ForceWare 262.99, который поставляется специально для этих видеокарт. Поскольку в тестировании принимали участие только видеокарты, поддерживающие API DirectX 11, в играх Heaven Benchmark 2, S.T.A.L.K.E.R: Зов Припяти и Dirt 2 мы использовали два режима настройки на максимальное качество. Таким образом, для этих игр были получены три, а не два результата. В этом тестировании, в отличие от предыдущих, не применяется такое понятие, как референсная конфигурация, а результаты сводятся к расчету интегральной оценки производительности по каждой отдельной игре (бенчмарку), которая не привязывается к референсной конфигурации. Поэтому для игр Heaven Benchmark 2, S.T.A.L.K.E.R: Зов Припяти и Dirt 2 среднегеометрическое бралось от двух полученных результатов — DX10 и DX11, чтобы получить более реальную картину производительности в этих играх и задействовать новый API DirectX 11. В остальных тестах среднегеометрическое бралось только от результатов при настройке на максимальное качество изображения. Для оценки полученных результатов мы также приводим результаты тестирования видеокарт Leadtek GeForce GTX480, AMD Radeon HD5870 и AMD Radeon HD5970.

Тестирование эффективности системы теплоотвода видеокарты заключалось в том, чтобы в стрессовом режиме загружать графический процессор и одновременно контролировать его температуру. Контроль температуры и загрузки графического процессора производился посредством программы FurMark 1.8.2. В некоторых случаях также применялись данные, которые предоставляет популярная сегодня утилита GPU-Z последней версии 0.4.8. Следует отметить, что поскольку в новых видеокартах и драйверах к ним применяется новая система мониторинга энергопотребления, есть вероятность того, что значения, полученные в результате этих тестов, не верны. Также обращаем внимание, что стенд для тестирования располагался на открытом пространстве (на столе), в реальных же условиях, когда ПК монтируется в корпусе, температура графического процессора будет несколько выше, если, конечно, в корпусе не установлены дополнительные вентиляторы охлаждения.

Результаты тестирования

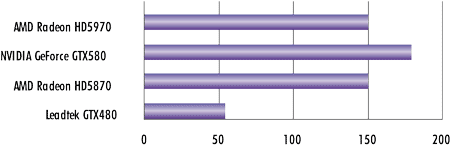

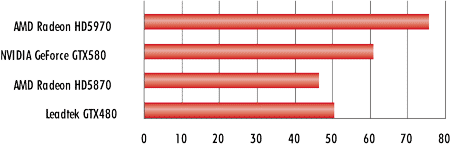

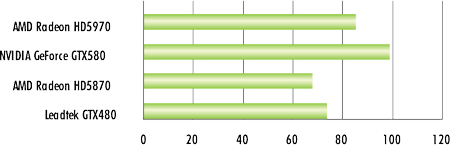

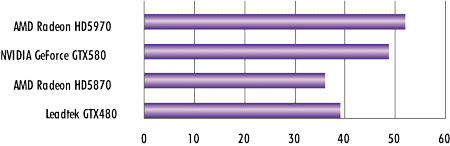

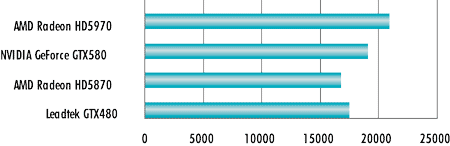

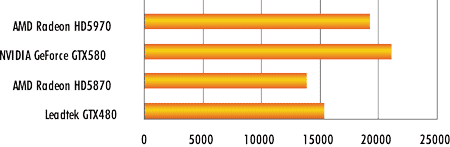

Сравнительные результаты тестирования в виде интегральных показателей для каждой игры представлены на диаграммах (рис. 1-10).

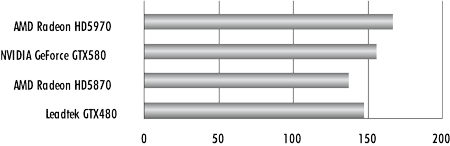

Рис. 1. Интегральный результат видеокарт

в игре Gun Metal Benchmark

Рис. 2. Интегральный результат видеокарт

в игре Call of Juares Demo

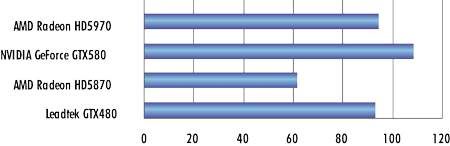

Рис. 3. Интегральный результат видеокарт

в игре S.T.A.L.K.E.R.: Зов Припяти

Рис. 4. Интегральный результат видеокарт

в игре Crysis

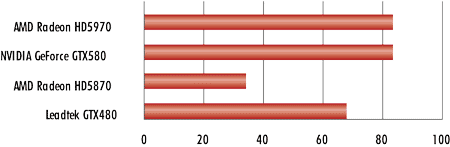

Рис. 5. Интегральный результат видеокарт

в игре Left 4 Dead 2

Рис. 6. Интегральный результат видеокарт

в игре FarCry 2

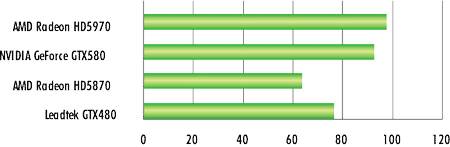

Рис. 7. Интегральный результат видеокарт

в игре Heaven Benchmark 2

Рис. 8. Интегральный результат видеокарт

в игре Dirt 2

Рис. 9. Интегральный результат видеокарт

в 3DMark06

Рис. 10. Интегральный результат видеокарт

в 3DMark Vantage

Технические характеристики видеокарты GeForce GTX580 в сравнении с видеокартой GeForce GTX480 представлены в таблице.

Видеокарта GeForce GTX580

Видеокарта GeForce GTX580 обеспечивает самую высокую производительность в современных играх среди однопроцессорных видеокарт, имеющихся на мировом рынке. Ее основные технические характеристики приведены в таблице, теперь рассмотрим ее внешний вид и систему охлаждения.

По конструкции новая модель повторяет видеокарты GeForce GTX460 и GTX470. Пластиковый корпус, скрывающий систему охлаждения в этой модели, выполнен в форме прямоугольника. В передней панели видеокарты располагаются три разъема для подключения мониторов: два DVI и один mini-HDMI. Поскольку последний не распространен в достаточной мере, в комплекте с видеокартой поставляется кабель-переходник шестиметровой длины, на одном конце которого находится HDMI-разъем, а на другом — mini-HDMI. Нельзя обойти вниманием тот факт, что кабели HDMI достаточно дорогие, поэтому идущий в комплекте кабель — большой плюс при выборе модели.

Кроме нововведений, касающихся аппаратной части графического чипа, в модели GeForce GTX 580 изменения коснулись системы охлаждения и отдельных элементов видеокарты. Так, несмотря на то что компания NVIDIA заявляет о сокращении энергопотребления всего на 6 Вт по сравнению с видеокартой GeForce GTX 480, реальные цифры впечатляют. При максимальной нагрузке на графические карты GeForce GTX480 и GeForce GTX580 разница составляет порядка 25 Вт в пользу GeForce GTX580. То есть при увеличении производительности на 10-15% видеокарта GeForce GTX580 потребляет энергии на 5-10% меньше. В режиме ожидания энергопотребление видеокарт практически не различается.

Для эффективного охлаждения графического ядра необходима правильно спроектированная система охлаждения. В видеокарте GeForce GTX480 система охлаждения была неоптимальной, и компании NVIDIA пришлось прибегнуть к помощи других компаний, чтобы добиться эффективного охлаждения GeForce GTX580. Ведь новая видеокарта имеет повышенные частоты ядра и памяти унифицированных процессоров. В целом о системе охлаждения для референсной модели GeForce GTX580 можно сказать, что это отлично проделанная работа над ошибками, которые были допущены в модели GTX480.

Система охлаждения, используемая в видеокарте GeForce GTX580, по своему принципу разительно отличается от предыдущих штатных систем охлаждения. За счет несколько пониженного энергопотребления, применения испарительной камеры в радиаторе и модифицированного вентилятора инженеры добились снижения общего шума, издаваемого GeForce GTX580. В новой системе охлаждения используется технология испарительной камеры, известная по оригинальным системам охлаждения некоторых производителей (например, Sapphire Vapor-X). Медная испарительная камера отбирает тепло у графического ядра, которое затем рассеивается при помощи массивного алюминиевого радиатора.

Отметим, что в этой модели применяется вентилятор с уменьшенной вибрацией и шумом, а новые алгоритмы управления частотой вращения PVM улучшают плавность вращения вентилятора при работе с большой нагрузкой на графический процессор. Кроме того, изменения коснулись системы мониторинга питания и нагрева. Если раньше видеокарты защищались от выхода из строя исключительно путем недопущения работы GPU при превышении критической температуры, то теперь проводится наблюдение за энергопотреблением всей системы. Исходя из информации, полученной от компании NVIDIA, новые элементы аппаратного мониторинга следят за силой тока и напряжением на 12-вольтных линиях питания. Драйвер контролирует значения этих параметров и может снизить тактовую частоту GPU при условии запущенных ресурсоемких приложений, если уровень питания превышает максимально возможный. Это ограничение работает только для заранее предопределенных в драйвере приложений, но не для игр. В процессе тестирования было выявлено, что это ограничение действует только в случае запуска приложения Furmark и OCCT (стрессовый тест).

Массивный алюминиевый радиатор с никелированным покрытием и медным основанием, отводящий тепло от своего медного основания, имеет достаточно большую площадь рассеивания. Основание радиатора замещает медная прослойка с узкой испарительной камерой, которая передает тепло от основания радиатора к его верхним точкам. В качестве вентилятора в этой модели используется 70-миллиметровый 4-контактный управляемый вентилятор производства компании Delta. При максимальной нагрузке на видеокарту ее графический чип нагревается до 86 °С, что на 6 °С меньше, чем у предыдущей модели GeForce GTX480.

В верхней части платы на привычном месте расположены 6- и 8-контактные разъемы питания видеокарты. На этой же части платы, но ближе к интерфейсам размещен двойной разъем SLI для связки нескольких видеокарт.

В отличие от моделей GeForce GTX460, в референсной видеокарте GeForce GTX580 используются микросхемы памяти GDDR5 производства компании Hynix, а не Samsung. Чипы памяти имеют маркировку H5GQ1H24AFR и номинальную частоту 1,25 ГГц. Поскольку микросхемы памяти в видеокарте работают на частоте чуть более 1 ГГц, у этой видеокарты есть небольшой запас по разгону.

При работе в режиме простоя графическое ядро нагревалось до температуры в 46 °С, при этом общее энергопотребление стенда составляло 92 Вт, а вентилятора практически не было слышно. При максимальной нагрузке на видеокарту с помощью программы FurMark 1.8.2 температура ядра поднялась до 86 °С и стабилизировалась на отметке 85 °С. При этом энергопотребление всей системы составило 370 Вт, а вентилятор системы охлаждения усиленно вращался, не издавая ощутимого шума. Стоит отметить, что энергопотребление более 350 Вт, было отмечено нами только на высокопроизводительных видеокартах. Это значительная цифра, поэтому при установке такой видеокарты необходимо иметь мощный блок питания — не менее 700 Вт. По сравнению с предыдущими референсными системами охлаждения от NVIDIA, новая система охлаждения стала работать гораздо более тихо и эффективно при больших тактовых частотах.

Выводы

Видеокарта GeForce GTX580 — это очень интересное решение с точки зрения полноценной поддержки API DirectX11. Новая модель продемонстрировала отличный потенциал в скорости работы тесселяции. В тестах Heaven Benchmark 2, Dirt 2 и S.T.A.L.K.E.R: Зов Припяти, которые имеют полноценную поддержку DirectX 11, видеокарта GeForce GTX580 значительно опередила своего прямого конкурента — AMD Radeon HD5870. Однако в некоторых других тестах, например в бенчмарках Call of Juares Demo (DirectX 10) и 3Dmark 06, а также в играх Dirt 2 (DirectX 11), Crysis (DirectX 10) и Left 4 Dead 2 (DirectX 10), она заметно проигрывала двухпроцессорной видеокарте AMD Radeon HD5970. В бенчмарке Heaven 2 обе видеокарты показали примерно одинаковые результаты при всех разрешениях. Однако, несмотря на проигрыш в некоторых тестах, можно уверенно утверждать, что GeForce GTX580 подняла планку производительности для однопроцессорной видеокарты еще выше, чем это сделала в свое время GeForce GTX480. И ее прямой конкурент — AMD HD5870 — осталась далеко позади.

Однако нельзя не отметить один недостаток новой модели — это ее высокое энергопотребление. Несмотря на проведенную работу над ошибками, двухпроцессорная видеокарта Radeon HD5970 всё равно потребляет меньше электроэнергии, чем однопроцессорная GeForce GTX580.

Зато новая модель NVIDIA на несколько сантиметров короче своих конкурентов, поскольку выполнена с соблюдением стандарта 270 мм. Это существенное преимущество, поскольку AMD Radeon HD5870 не помещается в некоторые корпуса из-за своей длины.

Рекомендованная розничная цена новой видеокарты составляет 17 999 руб., при этом ее главный однопроцессорный конкурент — видеокарта AMD Radeon HD5870 — имеет розничную цену порядка 15 тыс. руб., а двухпроцессорная видеокарта AMD Radeon HD5970 — 20 тыс. руб.

Новый графический адаптер поддерживает все современные технологии, а также все инновации NVIDIA. Видеокарты поддерживают режим SLI, что обеспечивает более высокий потенциал в игровых приложениях. Но стоимость подобной связки не сравнима с ценой на аналогичные решения конкурентов. Установка двух или трех таких карт даст одни из самых высоких значений производительности в играх на данный момент, даже в 3D-стереорежиме. Однако стоит учитывать, что для подобной связки требуются большой свободный корпус с дополнительным охлаждением и мощный блок питания (более 1000 Вт).

Итак, видеокарты на базе GeForce GTX 580 — самые быстрые однопроцессорные решения с хорошим потенциалом для будущих игр. Поскольку NVIDIA еще не выпустила в свет двухпроцессорного монстра на базе GTX580, пьедестал самой быстрой видеокарты новая модель делит с видеокартой AMD Radeon HD5970, которая хоть и сдала некоторые позиции, но всетаки обгоняет GeForce GTX580 в ряде приложений. Однако при примерно одинаковой стоимости модель от AMD очень громоздкая. Таким образом, новый графический чип от NVIDIA опять занял пальму первенства в классе hi-end-видеокарт.